Mit nur 0,27 Milliarden Parametern ist das Google-open-source-Gemma 3 die bisher kleinste Version, die auch auf Mobiltelefonen läuft. Bei 25 Konversationen wird weniger als 1 % des Akkus verbraucht.

Nachrichten von Zhidongxi vom 15. August. Heute hat Google das kleinste Open-Source-Modell Gemma 3 aller Zeiten vorgestellt, ein leichtgewichtiges Modell mit 270 Millionen Parametern. Die zugrunde liegende Architektur ist auf die Feinabstimmung für bestimmte Aufgaben ausgelegt und verfügt über starke Fähigkeiten zur Anweisungsbefolgung und Textverarbeitung.

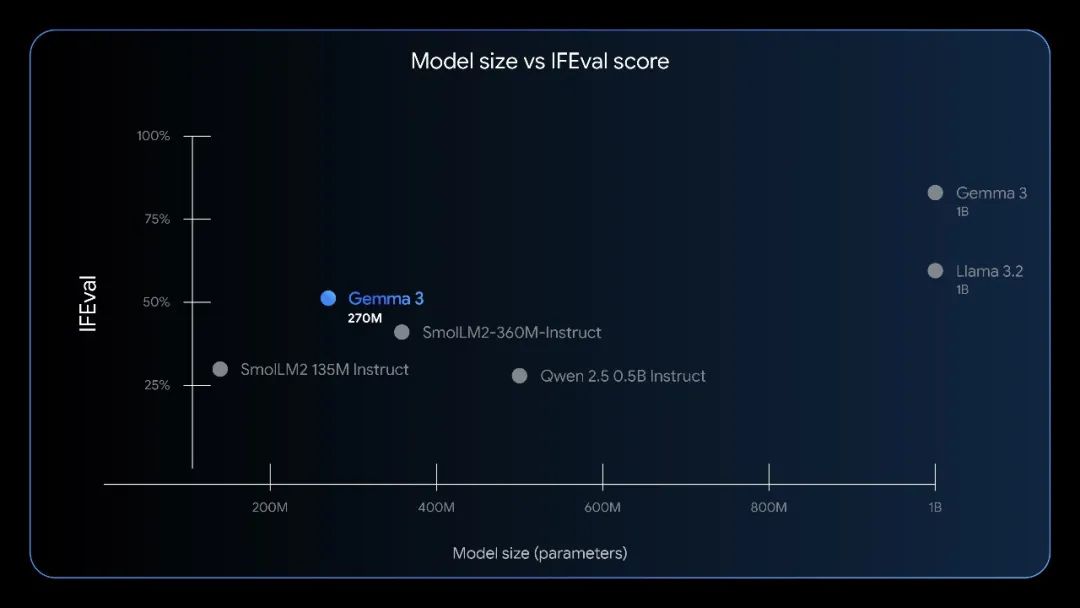

Im Test der Anweisungsausführungskapazität, wie im IFEval-Benchmark gezeigt, hat Gemma 3 270M das größer dimensionierte Qwen2.5 0.5B Instruct übertroffen und ist mit Llama 3.2 1B gleichwertig.

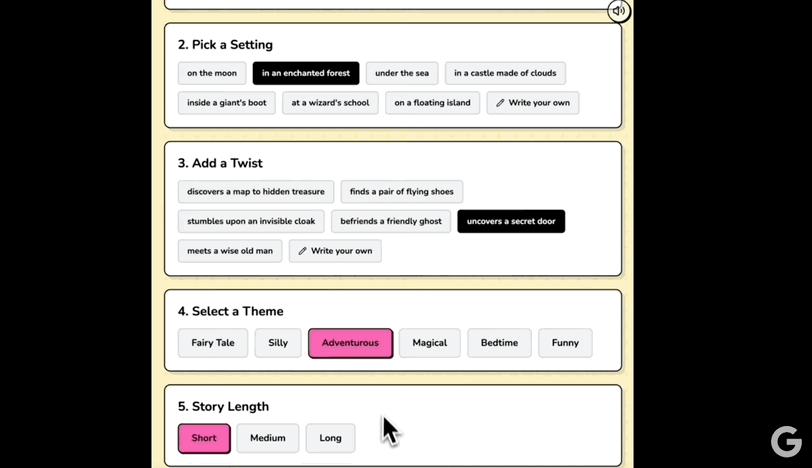

Gemma 3 270M kann in einigen bestimmten Aufgaben die Fähigkeiten großer Modelle erreichen oder sogar übertreffen. Die Größe und Leistung dieses Modells machen es sehr geeignet für offline und webbasierte kreative Aufgaben. Beispielsweise hat Google ein Beispiel veröffentlicht, in dem Gemma 3 270M eine Web-App zur Generierung von Abendgeschichten mit Transformers.js antreibt. Durch einfaches Ankreuzen können wunderbare Abendgeschichten generiert werden.

Die Kernfähigkeiten von Gemma 3 270M sind wie folgt:

1. Leichte und starke Architektur. Das Modell hat insgesamt 270 Millionen Parameter. Aufgrund des großen Vokabulars gibt es 170 Millionen Einbettungsparameter und 100 Millionen Parameter für die Transformer-Module. Dank des riesigen Vokabulars von 256.000 Tokens kann das Modell spezifische und seltene Tokens verarbeiten, was es zu einem ausgezeichneten Basismodell für die weitere Feinabstimmung in bestimmten Bereichen und Sprachen macht.

2. Maximale Energieeffizienz. Ein großer Vorteil dieses Modells liegt in seinem geringen Stromverbrauch. Interne Tests auf dem Pixel 9 Pro SoC haben gezeigt, dass das INT4-quantifizierte Modell bei 25 Gesprächen nur 0,75 % der Batterieleistung verbraucht, was es zum energieeffizientesten Gemma-Modell von Google macht.

3. Anweisungsbefolgung. Das Modell wurde gleichzeitig mit einer feinabgestimmten Anweisungsversion und einem Prätrainings-Checkpoint veröffentlicht. Obwohl das Modell nicht für komplexe Dialoganwendungen entwickelt wurde, hat es hervorragende Grundfähigkeiten zur Anweisungsbefolgung und kann "out of the box" auf allgemeine Anweisungen reagieren.

4. Quantifizierung für die Produktion. Das Modell bietet Checkpoints für die quantifizierungsbewusste Schulung (Quantization-Aware Trained, QAT), die die Ausführung mit INT4-Präzision unterstützen und nur minimale Leistungseinbußen verursachen. Dies ist für die Bereitstellung auf ressourcenbeschränkten Geräten (z. B. Mobiltelefonen, Edge-Geräten) von entscheidender Bedeutung.

Mit anderen Worten, wenn Benutzer eine Aufgabe mit hohem Volumen und klarer Definition haben, bei der Kosten sparsam eingesetzt werden müssen, schnelle Iterationen und Bereitstellungen erforderlich sind oder Datenschutzbedenken bestehen, ist Gemma 3 270M die richtige Wahl.

Hugging Face-Adresse: https://huggingface.co/collections/google/gemma-3-release-67c6c6f89c4f76621268bb6d

Fazit: Leichtgewichtige Modelle entfesseln Edge-Intelligenz

Bisher hat Google die Open-Source-Modelle von Gemma beschleunigt: Zuerst wurden Gemma 3 und Gemma 3 QAT für Single-Cloud- und Desktop-Acceleratoren veröffentlicht, anschließend wurde Gemma 3n vorgestellt, das leistungsstarke Echtzeit-Multimodal-AI direkt in Edge-Geräte einbringt. Die Veröffentlichung von Gemma 3 270M füllt die Lücke im Bereich der leichten Modelle.

Leichtgewichtige Modelle brechen den Glauben an die Parametergröße. In der Branche der großen Modelle besteht seit langem die festgefahrene Meinung, dass "die Parametergröße die Leistung bestimmt". Gemma 3 270M zeigt die Fähigkeit kleiner Modelle zur Anweisungsbefolgung und die Macht nach der Feinabstimmung. Mit leichten und starken Modellen können Benutzer kompakte, schnelle Produktionssysteme aufbauen, deren Betriebskosten deutlich gesenkt werden.

Dieser Artikel stammt aus dem WeChat-Account "Zhidongxi" (ID: zhidxcom), Autor: Li Shuiqing. Veröffentlicht von 36Kr mit Genehmigung.