Nicht dem typischen Transformer folgen: "Yuanshi Zhineng RWKV" erhält angelrunde Finanzierung in Millionenhöhe | 36Kr exklusive Veröffentlichung

36Kr erfuhr, dass das Unternehmen für Innovationen in der Großmodellarchitektur, Yuan Shi Intelligent (RWKV), im Dezember eine angelische Finanzierungsrunde in Höhe von mehreren zehn Millionen RMB abgeschlossen hat, wobei Tianji Capital als Investor auftrat. Nach dieser Finanzierungsrunde hat sich die Unternehmensbewertung im Vergleich zur Seed-Runde verdoppelt. Die Mittel werden hauptsächlich für die Teamerweiterung, die Iteration neuer Architekturen und die Kommerzialisierung von Produkten verwendet.

OpenAIs ChatGPT wurde im November 2022 veröffentlicht und hat eine weltweite Welle von generativer KI ausgelöst, die mittlerweile über zwei Jahre andauert. Die Technologiebasis dieser Revolution bilden die Transformer-Architektur und das Scaling Law (Skalierungsgesetz).

Der Grund, warum große Sprachmodelle (LLMs) Intelligenz aufweisen können, ist im Wesentlichen, dass die Parameter der KI-Modelle von Hunderten Milliarden auf tausende Milliarden expandiert wurden und die Modelle nach dem Lernen ausreichend vieler Daten Intelligenz zeigten.

Doch auch große Modelle haben ihre "Achillesferse" – Halluzinationen und Ungenauigkeit sind nahezu unlösbare Probleme. Im gerade vergangenen Jahr 2024 führte die Verlangsamung der Modelliteration zu einer großen Diskussion über die Transformer-Architektur und das Scaling Law (das besagt, dass durch die Erhöhung der Rechenleistung und des Datenvolumens die Modellleistung verbessert und mehr Intelligenz erreicht wird) in Wissenschaft und Industrie.

Die Gründung von Yuan Shi Intelligent (RWKV) zielte darauf ab, einen neuen Weg zu finden, der die Transformer-Architektur übertreffen könnte. "Wir sind nicht nur ein Großmodell-Unternehmen, sondern auch ein 'schwarzes Technologie'-Unternehmen, das ständig Innovationen in der grundlegenden Architektur von KI-Modellen realisieren kann", erklärte Luo Xuan, Mitbegründer von Yuan Shi Intelligent.

Gründer Peng Bo, Absolvent der Physikabteilung der Universität Hongkong und ehemaliger Quant-Trading-Experte, entschied sich ab 2020, RWKV als innovative Architektur und Open-Source-Projekt eigenständig zu entwickeln. Ende 2022 wurde das erste Modell von RWKV veröffentlicht, und im Juni 2023 wurde das Unternehmen offiziell gegründet, das Team wuchs von anfangs 3 auf fast 20 Mitglieder.

Im Gegensatz zur Transformer-Architektur, die auf große Rechenleistung und Daten angewiesen ist, verfolgt RWKV einen technisch effizienteren und flexibleren Ansatz.

"Einfach ausgedrückt, in der gegenwärtigen Mainstream-Transformer-Architektur, bei jedem Dialog, muss das Modell bei der Ausgabe eines Tokens den gesamten vorhergehenden Text erneut 'lesen' und stets den Zustand jedes vorherigen Tokens speichern (das heißt KV Cache).", erklärte Luo Xuan, Mitbegründer von Yuan Shi Intelligent. Dies führt dazu, dass Transformer keine effiziente Informationsverarbeitungsarchitektur sind und erhebliche Rechenleistung erfordern.

Der größte technologische Durchbruch von RWKV besteht darin, dass das Modell nicht ständig den Zustand jedes Tokens speichern muss – es muss nicht bei jedem Dialog den gesamten Text von Anfang an erneut lesen, was den Rechenaufwand erheblich verringert. Dies entspricht einer Kombination aus effizientem parallelem Training des Transformers und der effektiven Inferenzfähigkeit von RNNs.

RNNs (rekurrente neuronale Netzwerke) sind keine neue Technologie. Obwohl ihre Inferenzfähigkeit höher als die der Transformer ist, galt vor RWKV allgemein die Überzeugung, dass RNNs schwächer als Transformer sind. Doch das Auftreten von RWKV zeigte, dass die verbesserte Version des RNNs nicht nur effizienter als der Transformer blieb, sondern auch über eine starke Fähigkeit zum Sprachmodellieren verfügte.

Allerdings erfordert diese höhere Effizienz einen Preis: Als RNN mit fester Zustandsraumgröße kann RWKV nicht unbegrenzt lange Texte im gesamten Zustandsraum komprimieren. Das bedeutet, RWKV vergisst allmählich Details, die das Modell automatisch als "verzichtbar" einstuft (automatisch als wichtig eingestufte Details bleiben im Modellgedächtnis), und beantwortet Fragen, nachdem es den vorhergehenden Text einmal gelesen hat, ohne diesen erneut lesen zu müssen.

Peng Bo ist der Meinung, dass dies kein Mangel der RWKV-Architektur ist. So wie das menschliche Gehirn keine perfekte Gedächtnisleistung hat, können Menschen durch geringes Wiederholen und externe Gedächtnisunterstützung dennoch perfektes Lernen erreichen. RWKV kann durch die Einführung der RL (Reinforcement Learning)-Methoden bei Bedarf automatisch beurteilen, wann es notwendig ist, den Text erneut zu lesen. Diese Methode ist erheblich effizienter als das "erzwungene Speichern von allem" des Transformers.

Gleichzeitig eignen sich die Merkmale von RWKV auch für den Einsatz in bestimmten Szenarien, wie etwa beim Schreiben, bei der Musikgenerierung und in anderen kreativen Szenarien, bei denen die Ergebnisse des Modells innovativer und weniger "KI-artig" sein werden.

"Im kreativen Bereich der Musikgenerierung ähnelt die RWKV-Architektur mehr dem Gedächtnis- und Interpretationsmechanismus des menschlichen Gehirns, indem es nicht einfach Informationen der Vergangenheit durchsucht, sondern durch kontinuierliches Aktualisieren und Umsortieren neue Inhalte 'entsteht'", erklärte Luo Xuan.

Derzeit hat RWKV das Modelltraining von 0,1B auf 14B abgeschlossen, und die internationale Community hat das 32B-Vorschau Modell veröffentlicht. In den letzten zwei Jahren hat RWKV bedeutende technologische Durchbrüche erzielt: Die Architektur wurde von RWKV-4 schrittweise auf RWKV-7 iteriert.

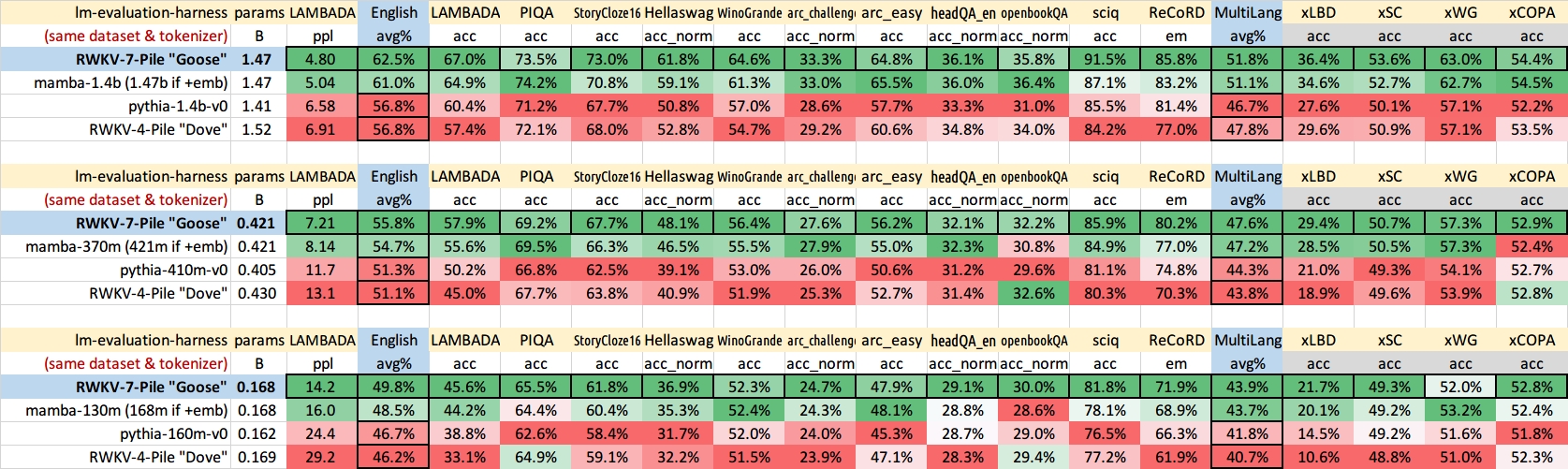

Das kürzlich veröffentlichte RWKV-7-Modell kann bei gleichgroßer Parametermenge die Leistung der Transformer-Architektur vollständig übertreffen. Diese Überlegenheit manifestiert sich in mehreren Dimensionen: Beispielsweise kann RWKV-7 die Genauigkeit schneller steigern als die vollständig optimierte Transformer-Architektur, wenn es um die Lerneffizienz des Modells geht. Bei Verwendung derselben Parameter und Trainingsdaten schneidet RWKV-7 auch bei Kern-Benchmarks wie dem Englisch- und Mehrsprachentest besser ab.

Quelle: RWKV

Das Gedächtnis von RWKV-7 ist im Vergleich zu vorherigen RWKV-Generationen signifikant stärker. Beispielsweise kann das RWKV-7 mit 0,1B Training auf einem 4k-Kontextfenster automatisch das 'Needle in a haystack'-Problem von 16k lösen.

"Das RNN-ähnliche Modell von RWKV ähnelt mehr der Funktionsweise des menschlichen Gehirns und des Universums, indem es durch effiziente Informationskompressionsmechanismen ermöglicht, dass das Modell mit begrenzten Ressourcen kontinuierlich lernen und sich weiterentwickeln kann.", sagte Luo Xuan.

Kontinuierliches Lernen ist ebenfalls ein signifikanter technologischer Durchbruch der RWKV-7-Version. Im Vergleich zum 'Train-Infer-Trennung'-Mechanismus der Mainstream-Modelle ermöglicht RWKV, dass das Modell 'während der Inferenz lernt' und die Muster im vorhergehenden Text besser erfasst.

Der hocheffiziente Inferenzmechanismus von RWKV ist besonders gut geeignet für Szenarien mit kleinen Modellen und auf Endgeräten – große Modelle sind zwar leistungsstark, stoßen jedoch auf zahlreiche Hardware-Einschränkungen: Egal ob auf Mobiltelefonen oder Computern, wenn keine ausreichend leistungsstarken Recheneinheiten vorhanden sind, ist es nicht möglich, das Modell lokal auszuführen, sondern man ist auf die Berechnung in der Cloud angewiesen, was die Benutzererfahrung verringert.

Derzeit teilt sich das Geschäft von Yuan Shi Intelligent in zwei Hauptbereiche: Einerseits wird das Modell Open Source gehalten, was vollständig Open Source und kostenlos bleibt – auf GitHub hat das Kern-Open-Source-Projekt RWKV-LM über 12.900 Sterne gesammelt, und es entstand allmählich ein Entwickler-Ökosystem. Derzeit nutzen mehrere Unternehmen und Universitäten wie Tencent, Alibaba, die Zhejiang-Universität und die Southern University of Science and Technology RWKV; andererseits gibt es die kommerzielle Einheit. Im Jahr 2024 wurden zahlreiche Produkttests durchgeführt, die sowohl den B2B- als auch den B2C-Bereich abdeckten.

Auf der Software-Seite hat RWKV eine KI-Musikgenerierungs-App für den Endverbrauchermarkt eingeführt. Im B2B-Bereich wählte Yuan Shi Intelligent die beiden Bereiche verkörperte Intelligenz und erneuerbare Energien, um Unternehmen mit Modelllizenzen zu versorgen. Zu den bisherigen Kunden gehören die State Grid Corporation und Deer Robot.

In Zukunft plant Yuan Shi Intelligent, im Jahr 2025 RWKV-7 mit Parametern von 70B oder mehr sowie Deployment-Szenarien für Endgeräte zu veröffentlichen und durch die Integration neuer Inferenz-Frameworks und neuer Chips die Erkundung größerer Modelle zu ermöglichen. Luo Xuan sagte, dass mit der Wende der Skalierungsgesetze im ersten Halbjahr 2025 ein Boom neuer Architekturen erwartet wird und Yuan Shi Intelligent dann die Kommerzialisierung beschleunigen wird.

Willkommen zum Folgen