„Houmo Intelligence“ Ni Xiaolin: Die nächsten zehn Jahre gehören dem Zeitalter der großen Modelle, NPUs werden alle Edge-Szenarien neu gestalten | WISE2024 King of Business Konferenz

Am 28. und 29. November fand die zweitägige 36Kr WISE2024 Business King Konferenz in Peking statt. Als glanzvolles All-Star-Event im chinesischen Geschäftssektor ist die WISE-Konferenz in diesem Jahr bereits die zwölfte Ausgabe und bezeugt in einer sich ständig verändernden Zeit die Widerstandsfähigkeit und das Potenzial der chinesischen Wirtschaft.

2024 ist ein Jahr, das eher verschwommen erscheint und mehr Veränderungen als Stabilität zeigt. Im Vergleich zu den letzten zehn Jahren verlangsamt sich das Tempo, die Entwicklung wird vernünftiger. 2024 ist auch ein Jahr, in dem neue wirtschaftliche Antriebskräfte gesucht werden, und die Veränderungen in der Industrie stellen höhere Anforderungen an die Anpassungsfähigkeit jedes Akteurs. In diesem Jahr steht die WISE-Konferenz unter dem Motto "Hard But Right Thing" (Richtiges tun), und wir möchten in 2024 über das austauschen, was richtig ist.

An diesem Tag hielt der Vizepräsident von "Houmo Intelligence", Ni Xiaolin, eine Hauptrede und teilte die unbegrenzten Möglichkeiten und tiefgreifenden Auswirkungen von KI und NPU mit.

Im Folgenden der Inhalt der Rede (bearbeitet und zusammengefasst von 36Kr)

Ni Xiaolin: Sehr geehrte Gäste, herzlich willkommen!

Ich bin Ni Xiaolin von "Houmo Intelligence", einem Unternehmen für KI-Chips, die auf einer Computing-in-Memory-Architektur basieren. Heute wird in jedem Segment über KI gesprochen, verschiedene große KI-Modelle, KI-Geräte und KI-Anwendungsszenarien entwickeln sich rasant. Als Teilnehmer und Zeuge des großen KI-Zeitalters fühlen wir uns sehr geehrt. Im Folgenden möchte ich einige Ansichten von Houmo Intelligence zur Veränderung der Rechenleistung auf der Edge-Seite teilen.

Houmo Intelligence

Im November 2022 veröffentlichte OpenAI ChatGPT3.5, was den Beginn des KI 2.0-Zeitalters markierte; im Jahr 2023 wurden viele lokale große Modelle veröffentlicht. KI begann sich gleichzeitig in zwei Richtungen rasant zu entwickeln. Cloud-Modelle entwickeln sich gemäß dem Scaling Law weiter und steigern die Modellgröße und Parameter, um die Grenzen der allgemeinen Intelligenz weiter zu erkunden. Zum Beispiel hatte das letztes Jahr veröffentlichte GPT4 beeindruckende 1500B Parameter, also 1500 Milliarden Parameter. Doch das Streben nach hoher Allgemeinheit und hohem IQ bringt gleichzeitig enorm hohe Investitions- und Betriebskosten mit sich. Derzeit ziehen sich bereits viele Spieler von diesem hohen Wettlauf zurück.

Gleichzeitig sind auf der Edge-Seite Modelle wie 7B, 13B und 30B aufgetaucht, die sich besser für die lokale Bereitstellung eignen. Im Vergleich zu großen allgemeinen Intelligenzmodellen eignen sich diese Modelle besser, um in alle möglichen Branchen einzusteigen und spezifische Probleme zu lösen. Im Vergleich zur cloudbasierten "All-Modell-Ausgabe, All-Modell-Konkurrenz" hat die Edge-Seite unbestreitbar ein größeres Anwendungspotential. Jedes Jahr werden weltweit Dutzende von Milliarden neuer intelligenter Geräte hinzugefügt, und die skalierbare Vorstellungskraft der Edge-Seite ist größer und vielversprechender.

Außerdem hat die Edge-KI Vorteile wie Personalisierung, niedrige Latenz und Datenschutz. Beispielsweise ein KI-PC, der über einen persönlichen Agenten verfügt, der deine persönlichen Informationen kennt, und eine lokale Datenbank, die auf deinen historischen Dokumenten basiert.

Natürlich sehen wir derzeit noch mehr Diskussionen über Cloud-Modelle, während die Edge-Seiten-Modelle noch nicht verbreitet sind. Neben diesen Software-Faktoren gibt es auch einen sehr wichtigen Einflussfaktor – die Hardware. Die Anforderungen der Edge-Seite an Hardware unterscheiden sich von denen der Cloud und lassen sich in "drei hoch, drei niedrig" zusammenfassen: Hohe Rechenleistung, hohe Bandbreite, hohe Genauigkeit, niedriger Stromverbrauch, niedrige Latenz, niedrige Kosten.

Ein CPU kann offensichtlich nicht alle Anforderungen erfüllen, und obwohl ein GPU die drei Hochwerte erfüllen kann, schränken die hohen Kosten und der hohe Stromverbrauch gleichzeitig die weit verbreitete Nutzung von Edge-Geräten erheblich ein. Zum Beispiel, wenn ein 30B-Modell lokal ausgeführt wird, benötigen wir eine 4090-Grafikkarte, aber die fast 20.000 Yuan Kosten und der fast 500W Stromverbrauch sind für die meisten Geräte untragbar.

Im Gegensatz zur cloudbasierten "Training"-Szene sind große Edge-Modelle meist auf das "Inferencing"-Szenario fokussiert. NPUs, die speziell für lokale große Modelle entwickelt wurden, sind zweifellos besser für den Einsatz auf der Edge-Seite geeignet. Wir können beispielsweise mit einem Zehntel des Stromverbrauchs die gleiche Rechenleistung wie ein GPU erzielen. Darüber hinaus verfügt das NPU über einen großen internen Speicher, der nicht über den Systembus auf den Systemspeicher zugreifen muss und somit vollständig unabhängig und flüssig arbeitet. Die Kosten für ein NPU sind ebenfalls deutlich günstiger als für ein GPU, was das Vorhandensein von Geräten mit KI möglich macht.

In Anbetracht der hohen Bandbreiten-, niedrigen Energiebedarfe von Edge-Geräten ist die traditionelle Von-Neumann-Architektur bereits mit erheblichen Herausforderungen konfrontiert, insbesondere der Speicher- und Energiebedarf, unter dem viele Unternehmen bereits gelitten haben.

Der Speicherbedarf bezieht sich auf die Tatsache, dass die begrenzte Busbandbreite die Datenübertragungsgeschwindigkeit erheblich einschränkt.

Der Energiebedarf bezieht sich darauf, dass über 90 % des Stromverbrauchs für den Transport von Daten aufgewendet werden, nicht für die tatsächlich benötigte Berechnung und Verarbeitung.

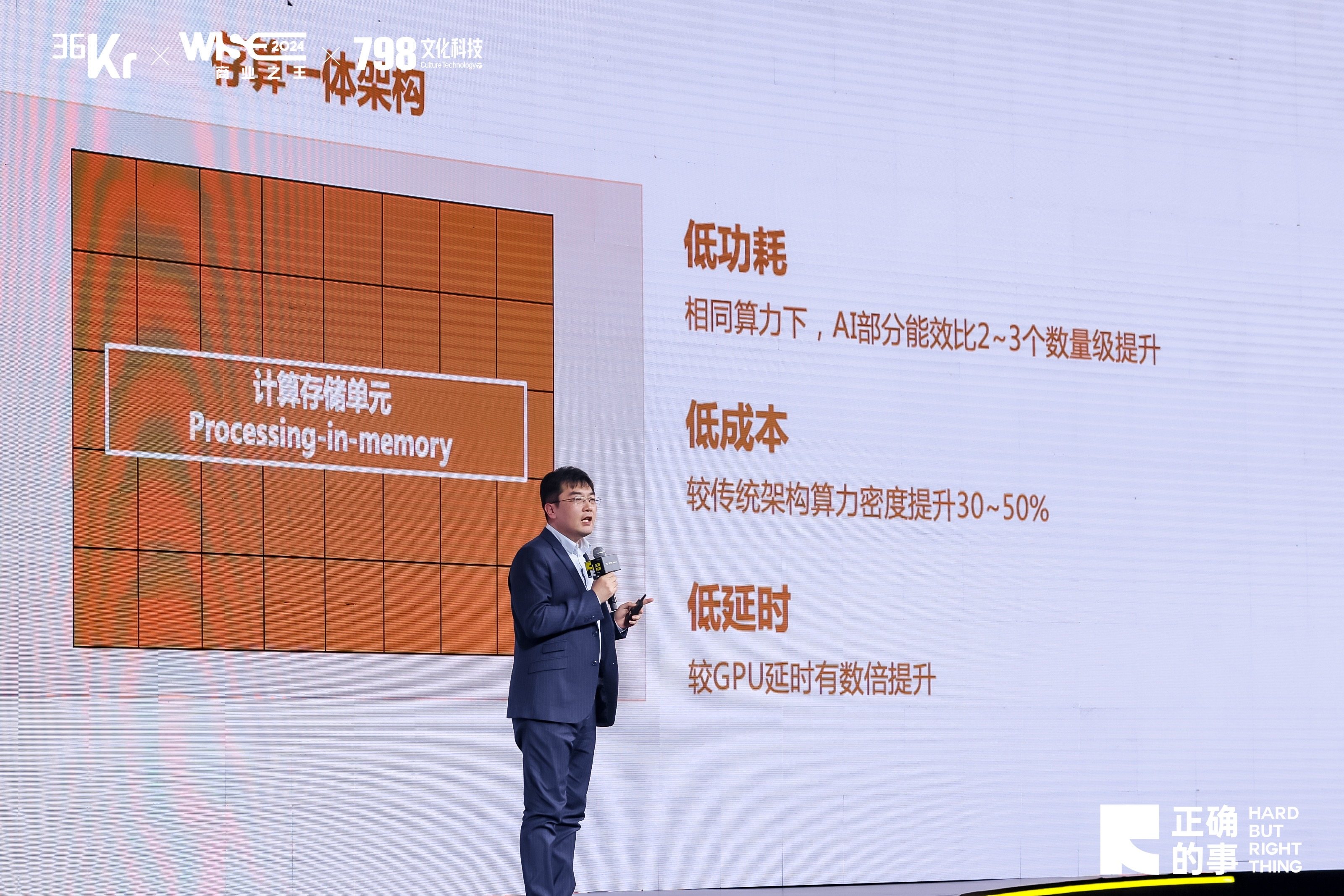

In Anbetracht dieser beiden hohen Barrieren hat Houmo Intelligence eine neue Architektur für integriertes Computing-Speicher entwickelt, die eine hohe Integration von Speichereinheiten und Recheneinheiten ermöglicht, indem die Berechnung direkt in den Speichereinheiten erfolgt, was den Energiebedarf erheblich senkt und die Bandbreite erheblich erhöht.

Die integrierte KI-Chip-Architektur hat die Efficency Ratio von KI um 2-3 Größenordnungen verbessert. Die Rechenleistung pro Fläche ist um bis zu 50% erhöht, und die Latenzzeiten sind im Vergleich zu herkömmlichen Architektur-Chips um ein Vielfaches verbessert. Diese Eigenschaften sind sehr gut geeignet für die Bedürfnisse von großen Edge-KI-Modellen.

Houmo Intelligence

Derzeit hat Houmo Intelligence bereits zwei Generationen von integrierten Speicher- und Rechenchip-Architekturen selbst entwickelt, speziell für LLM-große Modelle wurde eine spezielle Designmaßnahme getroffen.

Diese Merkmale spiegeln sich hauptsächlich in:

1. Der selbst entwickelten IPU-Architektur mit integrierten Speicher- und Recheneinheiten, die hochparallele Gleitkomma- und Ganzzahlrechenleistung bieten. Die selbst entwickelte SFU unterstützt verschiedene nichtlineare Operatoren, und die selbst entwickelte RVV-Multicore bietet enorme allgemeine Rechenleistung und kann flexibel verschiedene LLM/CV-Algorithmen unterstützen. Die selbst entwickelte C2C-Schnittstelle bietet die Eigenschaft der Kaskadierung mehrerer Chips, wodurch größere Modellbereitstellungen ermöglicht werden.

2. Die begleitende "Houmo Avenue" Software-Toolchain ist einfach und benutzerfreundlich und kompatibel mit gängigen Programmiersprachen. Der Operator-Bibliothek passt sich der integrierten Speicher- und Recheneinheit-Architektur an, nutzt die durch die Speicherrechnungs-IP erzielten Leistungs-/Energieverbrauchsvorteile effektiv aus und verkürzt die Einsatzzeiten erheblich.

In den Jahren 2023 und 2024 haben wir die NPU-Chips Houmo Honghu®️H30 und Houmo Manjie®️M30 eingeführt, die die enormen Vorteile der integrierten Speicher- und Rechnerarchitektur hinsichtlich Rechenleistung und Energieverbrauch voll zur Schau stellen. Zum Beispiel liefert der M30-Chip eine beeindruckende Rechenleistung von 100Tops bei einem Energiebedarf von nur 12W.

In diesem Zusammenhang möchte ich schon heute ankündigen, dass wir im Jahr 2025 den neuesten Chip auf Basis der neuen "Tianxuan"-Architektur veröffentlichen werden. Dieses Produkt wird die Leistung weiter massiv steigern und wir glauben, dass dieser Chip den Prozess der Bereitstellung von großen Modellen auf Edge-Geräten beschleunigen kann.

Houmo Intelligence

Um das schnelle Deployment von KI-Gerätelösungen und -Herstellern zu erleichtern, bieten wir nicht nur Chips, sondern auch verschiedene standardisierte Produktformen an, einschließlich Limou®️LM30 Smart Accelerator Card (PCIe), Limou®️SM30 Computing Module (SoM) usw. Für bestehende Endgeräte aller Art kann durch die Installation eines NPU über standardisierte Schnittstellen eine flüssige lokale Ausführung großer KI-Modelle erreicht werden.

Der Aufstieg des mobilen Internets im Jahr 2009 verwandelte unsere Telefone von Funktionshandys in Smartphones. Der Ausbruch des Internet of Things im Jahr 2016 machte immer mehr Geräte in unserer Umgebung zu intelligenten Geräten. Diese intelligenten Geräte werden auf der bestehenden Lösung durch die + KI + NPU-Methode erneut weiterentwickelt, um zu Geräten zu werden, die große KI-Modelle ermöglichen.

Zum Beispiel sehen wir auf dem PC, dass Lenovo bereits KI-PCs in großem Umfang fördert. KI-Cockpits in Autos, KI-Fernseher, KI-Konferenzbildschirme, verkörperte intelligente Roboter und mehr werden zu intelligenteren, intelligenteren und effizienteren Assistenten, Sekretären, Fahrern, Textern, Designern, Programmierern, Tutoren usw. für uns werden, die eine Vielzahl von Dienstleistungen anbieten. Wir hoffen, dass Houmo Intelligence KI-Chips Sie bei der schnellen Aufrüstung unterstützen können.

Von 1999 bis 2008 ließ das Internet fast alle Branchen in China neu gestalten; von 2009 bis 2018 gestaltete das mobile Internet fast alle Branchen in China neu. Wir glauben, dass NPUs im kommenden Jahrzehnt des großen KI-Modellzeitalters alle Edge-Szenarien neu gestalten werden. Jedes Edge-Gerät wird neu gestaltet!

Wir hoffen, dass wir mit allen anwesenden KI-Unternehmen und KI-Ökosystem-Partnern viel Kommunikation betreiben und gemeinsam zusammenarbeiten können, um durch "+ KI" sicherzustellen, dass bestehende Geräte und alle neu entstehenden Geräte flüssig großene KI-Modelle ausführen können. Wir freuen uns darauf, gemeinsam mit Ihnen eine neue Ära der KI zu schaffen, vielen Dank!