Die KI hat das erste rote Paket in der Menschheitsgeschichte verschickt.

Text|Deng Yongyi

Redaktion|Su Jianxun

Am 29. November, auf dem Open Day von Zhipu AI, erreichte die Atmosphäre ihren Höhepunkt, als Zhipu-CEO Zhang Peng zweifellos sein Handy hob und der KI sagte: Hilf mir, einen Red Envelope im Wert von 20.000 in der Gruppenchat des Zhipu Open Day zu senden, verteilt auf hundert Leute, mit dem Namen "Der erste Red Envelope, den die KI dir schickt".

Daraufhin rief die KI sofort WeChat auf, öffnete die Funktion zum Versenden von Red Envelopes und veröffentlichte erfolgreich den Beitrag.

"AGI ist nicht nur ein ChatBot, ein Sprachmodell, sondern besteht auch nicht nur aus Modellparametern", so Zhang Peng, CEO von Zhipu AI.

△ Quelle: Zhipu AI

Dies kann auch erklären, warum 2024 das Agent-Fieber weltweit an Fahrt aufnimmt – von globalen Größen wie Google bis hin zu nationalen Giganten wie Baidu, Alibaba, Bytedance usw., alle stellen ihre eigenen Agent-Produkte vor.

Branchenweit herrscht Einigkeit darüber, dass 2025 das Jahr des Durchbruchs für Agenten sein wird. Gartner hat vor kurzem agentische KI als einen der zehn wichtigsten Technologietrends für 2025 gelistet und prognostiziert, dass zumindest 15% der täglichen Arbeitsentscheidungen bis 2028 von agentischer KI autonom getroffen werden. Diese Zahl beträgt 2024 noch 0.

Ein Agent kann als ein KI-Agent betrachtet werden, der den Menschen bei der Durchführung von prozessbezogenen Softwareoperationen unterstützt.

Zhang Peng fasste die Essenz von AI Agenten mit einem Satz zusammen: "Wir denken auch ständig darüber nach, was die 'Sequenzvorhersage' von großen Modellen bedeutet und in welcher Form sie effizient angewandt werden kann. Was, wenn die Vorhersageform nicht nur auf sprachlichen Text beschränkt ist, sondern auf Bild- und Videomaterial sowie auf Operationssequenzen erweitert wird?"

Die Durchführung von Operationssequenzen oder Aufgaben ist im Wesentlichen AutoGLM.

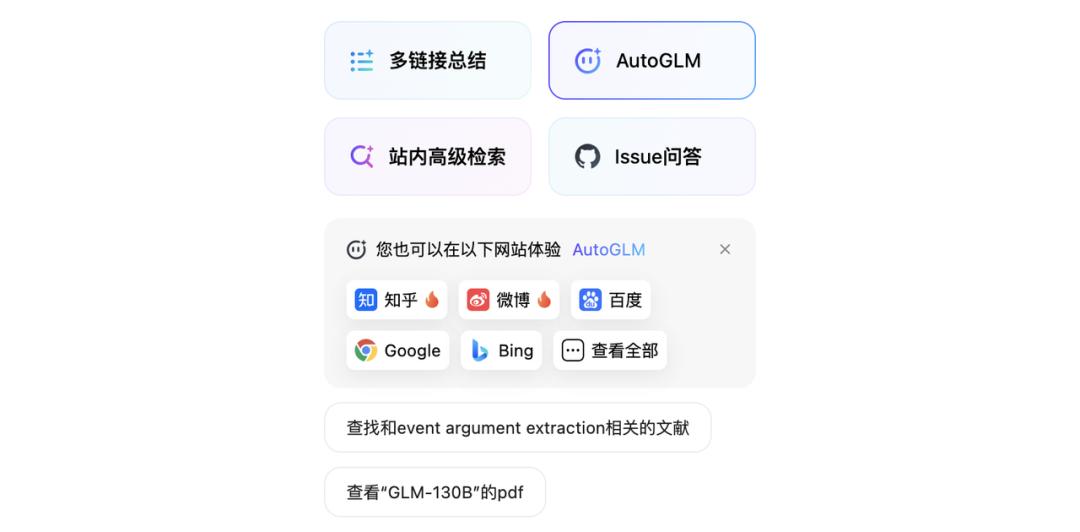

Die Form von AutoGLM ist ein Assistent auf App-, Web- und PC-Endgeräten. Zhipu hat auf der heutigen Pressekonferenz entsprechende Produkte für diese drei Endgeräte vorgestellt:

AutoGLM kann lange, aus mehr als 50 Schritten bestehende Operationen selbstständig ausführen und auch Aufgaben über verschiedene Apps hinweg erledigen.

AutoGLM eröffnet ein neues "vollautomatisches" Interneterlebnis und unterstützt dutzende Websites im autonomen Modus.

GLM-PC, wie ein Mensch, der den Computer bedient, startet offiziell den Betatest und erforscht visuelle Modelle für einen universellen Agenten.

Bereits vor einem Monat hat Zhipu eine Betaversion von AutoGLM veröffentlicht, die schon über eine Million Nutzer angezogen hat. Die Demo kann bereits in Apps wie WeChat, Taobao, Meituan und Xiaohongshu operieren, um Aufgaben wie das Versenden von Red Envelopes und das bestellte Abholen von Kaffee via Alipay zu erledigen.

Auf der heutigen Pressekonferenz hat AutoGLM seine Fähigkeiten erweitert – unterstützte Apps umfassen nun Douyin, Weibo, JD, Pinduoduo und andere, und was noch wichtiger ist, es kann Operationen über verschiedene Apps und Endgeräte hinweg ausführen.

△ Restaurant suchen + Buchungsszenarien Quelle: Zhipu AI

Ein Beispiel war in der Live-Demo zu sehen: Das Zhipu-Qingyan-Plugin hat automatisch "Suche Mango TV, öffne Little Alley, spiele die neueste Episode, sende eine Kommentarblase zum Finale" ausgeführt. Alles ohne menschliches Eingreifen.

In einem anderen Beispiel mit der Beschaffung von Zutaten für ein Hot Pot, hat AutoGLM 54 Schritte vollständig ohne Unterbrechung ausgeführt. Auch in mehrstufigen und zyklischen Aufgaben war die Geschwindigkeit von AutoGLM besser als die von manueller Bedienung.

△ Quelle: Zhipu AI

Zhang Peng nutzte auch sein Handy, um Weibo aufzurufen und wie ein Mensch zu agieren: Er öffnete das Weibo-Profil eines Stars und hinterließ einen Textkommentar zu einem Beitrag - auch diese Aufgabe bewältigte die KI problemlos.

Auf dem PC können zudem viele tägliche Aufgaben erledigt werden, darunter die Buchung und Teilnahme an Besprechungen für den Benutzer, das Versenden von Besprechungszusammenfassungen; Unterstützung von Dokumentdownloads, Dokumentversand, Verständnis und Zusammenfassung von Dokumenten usw.

△ Quelle: Zhipu AutoGLM

Außerdem wird die informationsübergreifende Suche und Zusammenfassung zwischen Anwendungen unterstützt - z. B. das Suchen und Zusammenfassen bestimmter Schlüsselwörter auf Plattformen wie WeChat Official Accounts, Zhihu, Xiaohongshu usw.

Auf den ersten Blick einfach, aber Agenten können diese Aufgaben nur mit umfangreichen Operationen und Berechtigungen erfüllen. Zum Beispiel gibt es bei WeChat eine strenge Anti-Crawling-Politik, und wenn ein Bot erkannt wird, wird er schnell blockiert. Sogar das Kopieren von Inhalten aus Xiaohongshu-Beiträgen ist schwierig - in der Vergangenheit war es üblich, dass Nutzer zunächst Screenshots machten und dann mit anderer Software den Text extrahierten.

Agent ist kein neuer technologischer Begriff, sondern existiert bereits seit Jahrzehnten.

Bestrebungen, Maschinen bei der Bewältigung von Softwarearbeiten zu unterstützen, gibt es auch in Bereichen wie iPaaS, RPA (Robotic Process Automation, kurz RPA) und traditionellerem BPM (Business Process Management). Alle sind daran interessiert, prozessbezogene, repetitive Arbeiten zu automatisieren.

Allerdings stießen frühere Technologien auf verschiedene Herausforderungen hinsichtlich Genauigkeit und Durchführbarkeit, darunter Schwierigkeiten beim korrekten Erfassen von AI-Bildelementen oder bei niedrigem Niveau der API-Öffentlichkeit für verschiedene Software. Doch mit dem Aufkommen großer Modelle lassen sich diese Probleme lösen - große Modelle können die Bedeutung von Softwareoberflächen klar verstehen und zeigen keine Erkennungsfehler aufgrund geringfügiger Änderungen von Bildelementen.

AutoGLM-Technikleiter Liu Xiao erklärte gegenüber 'Intellektuelle Emergenzen', dass AutoGLM den Benutzer bei Operationen unterstützt, da es auf "Nutzerautorisierte interaktive Oberflächen" setzt - im Wesentlichen wird menschliches Eingreifen simuliert, was grundlegend anders ist als API- oder Maschinenaufträge.

Ohne Zweifel sind verkörperte Intelligenz und Agenten das ganze Jahr 2024 über ein heißes Thema. Die Technologie der großen Modelle befreit sich von reinem Modellniveau und wechselt zu einer Beeinflussung der Mensch-Maschine-Interaktion - sie verbessert das Verständnis von Anforderungen, Planung und Entscheidung, Handlungsausführung und Selbstreflexion, wodurch Maschinen den Menschen besser verstehen und Aufgaben effizienter erledigen können.

Dies spiegelt sich auch in den jüngsten Debatten über Scaling Laws wider.

Scaling Law ist ein wichtiges Prinzip zur Förderung der Iteration großer Modelle. In den zwei Jahren seit der Einführung von ChatGPT haben sich Hersteller von großen Modellen auf Pre-Training konzentriert - um den Modellen mehr hochwertige Daten zuzuführen, damit sie ab einer bestimmten Größe Intelligenz entfalten können.

Doch mit der Veröffentlichung des neuen Modells o1 durch OpenAI im September, deutet dies auf eine Wendung des Scaling Laws hin - von größeren Modellen hinsichtlich Training und Parametern zu erweiterter Nach-Training, das den Modellen mehr Denkzeit anstelle von mehr Parametern verschafft, sodass sie komplexere, schwierigere Fragen behandeln können.

△ Quelle: Zhipu AI

Zhang Peng ist der Ansicht, dass das heute vorgestellte AutoGLM lediglich den "Einschluss" der Fähigkeiten der GLM-Modellfamilie darstellt, sowie den Beginn und Versuch, ein intelligentes KI-Betriebssystem zu erreichen.

Scaling ist nicht nur "Aus meiner Sicht stimme ich der Ansicht zu, dass Berechnung die entscheidende Komponente ist - nämlich nützliche Informationen."

„Derzeit stellt AutoGLM eine Zwischenschicht zwischen Mensch und Anwendung dar, die die Interaktionsweise erheblich verändert. Was noch wichtiger ist, ist die Möglichkeit eines LLM-OS, das auf der Intelligenz großer Modelle (von L1 bis L4 und darüber hinaus) basiert und eine natürliche Mensch-Maschine-Interaktion realisieren könnte. Dies wird die Interaktionsmuster von Mensch und Maschine auf eine neue Ebene heben.“

Nachfolgend ein Interview mit dem Zhipu-CEO Zhang Peng und dem AutoGLM-Technikleiter Liu Xiao nach der Veranstaltung, zusammengefasst von "Intellektuelle Emergenzen":

Intellektuelle Emergenzen: Zum Beispiel schaffen viele große Unternehmen wie Meituan oder Douyin ihre eigenen Agenten. Nachdem wir AutoGLM auf den Markt gebracht haben, wie denken Sie über die ökologische Nische? Die Software, einschließlich einiger Endgeräte, hat eine große Anwendungsbarriere, und einige grundlegende Berechtigungen sind schwer zu überbrücken. Wie löst Zhipu dieses Problem?

Zhang Peng: Dies ist sowohl eine geschäftliche als auch eine technische Angelegenheit.

Liu Xiao: AutoGLM soll ein zentrales Werkzeug werden, das Menschen bei der besseren Verbindung von Hardware, Anwendungen und Diensten unterstützt. Durch den Einsatz von natürlicher Sprache können Nutzer auf einfachere Weise verschiedene Funktionen kombinieren und ihrem persönlichen Willen nachgehen.

Technisch gesehen ist es eine Herausforderung. In ihrem eigenen geschlossenen System können Unternehmen Daten erhalten und Designs selbst erstellen, aber das schränkt die Zusammenarbeit und das Verbinden mit anderen ein. Auch unsere Modelle sind nicht intelligent genug, um stärkere Verknüpfungen herzustellen.

Unser nächster Schwerpunkt ist es, die Modelle mit den Anwendungen der großen Unternehmen zu verbinden. Das ist ein zentrales Entwicklungsthema für uns.

Zhang Peng: Aus geschäftlicher Sicht betrachtet handelt es sich um einen gegenseitig vorteilhaften Ansatz. Wir schaffen eine grundlegende Plattform, auf der alle neuen Hersteller auf ihre Weise davon profitieren können. Zum Beispiel können ihre eigenen Agentensysteme mehr Plattformen einbinden.

Q: Ich möchte ein technisches Detailbesprechen. Um komplexe Geschäftsprozesse zu erledigen, benötigen Agenten riesige Datenmengen und Anwendungen. Viele Websites und Apps verwenden aber individuelle, nicht standardisierte APIs. Das erschwert den Einsatz von Agenten. Wie lösen Sie das?

Liu Xiao: Die Grundlage von AutoGLM ist die grafische Benutzeroberfläche und unterscheidet sich grundlegend von API-Befehlen, da menschliche Aktionen nachempfunden werden.

Wenn man früher APIs verwendete, und eine Anwendung aktualisiert wurde, funktionierten sie unter Umständen nicht mehr.

Durch Benutzeroberflächen wird dies verhindert, solange die Oberfläche für Menschen verständlich ist und als Software genutzt wird.

Q: Warum wurde letztes Jahr nicht so viel über Agenten gesprochen? Was hat sich geändert?

Zhang Peng: Im vergangenen Jahr wurden diese Themen weniger angesprochen, weil die dafür nötigen Technologie noch nicht reif genug war. Die Implementierung komplexer Aufgaben war aufgrund der Fähigkeiten der Modelle nicht zufriedenstellend.

Das Modell bezieht sich auf Szenarien der Mensch-Maschine-Interaktion. In der Vergangenheit betraf dies überwiegend Unternehmensanwendungen, die für normale Nutzer nicht sichtbar sind.

Mit technischen Fortschritten und wachsendem Interesse machen nun mehr Tech-Unternehmen Experimente, wodurch Verbrauchergelegenheiten deutlicher zu spüren sind.

Q: Gibt es einen Dämpfer für die Scaling Law? Was ist Ihre Meinung dazu? Wie wird Zhipu darauf reagieren?

Zhang Peng: Heute haben wir gezeigt, wie wir die Grenzen menschlichen Denkens überschreiten könnten. Dazu benötigen wir riesige Datenströme und Massenverarbeitung.

In multidisziplinären Bereichen können Agenten zur Skalierung genutzt werden, was Skalierungen zu versuchen lohnenswert macht.

Die Verlangsamung von Eingrenzungen ist nur eine Beobachtung; sie reflektiert nicht das System. Über seine Essenz diskutieren wir fortlaufend.

Ich bin der Ansicht, dass Berechnung die entscheidende Komponente nützlicher Informationen darstellt.

Zwar hat das Pre-Training nachgelassen, doch das Nach-Training zeigt immer noch Scaling-Wirkungen, jedoch nicht so direkt über Kapazität und Parameter wie im Pre-Training-Phase.

Q: Die Agententechnik scheint vielversprechend, aber wie kann sie noch mehr Effizienz erreichen, bis zu 50-80% unserer Geräteanwendung beispielweise?

Liu Xiao: Im heutigen Vortrag wurde die Pre-Training Scaling Law aufgrund der Datenlage als begrenzt erkannt, aber das o1-Modell zeigte, dass Agent-Scaling neue Wege ermöglicht.

Wer neugierig auf Entwicklungen war, wird bald Fortschritte feststellen. Die Pre-Training-Phase bietet noch Potenzial, doch es bedarf neuer Algorithmen und Methoden.

Q: In der Anfangsphase gab es GLM OS, und heute fokussieren Sie sich auf B2C-Agenten. Wurde der ursprüngliche OS-Ansatz fallen gelassen?

Zhang Peng: Es ist kein Aufgeben, sondern ständige Anpassung und Evaluation sind nötig. Der ursprüngliche OS-Ansatz eröffnete Wege zu spannenden Kapazitäten, die in den Agenten mündeten.

Die Potenziale sind bedeutend; deshalb spezifizieren wir diese Kapazitäten. Der Ursprung wird genutzt, um neuartige Anwendungsmöglichkeiten zu entfalten.

In naher Zukunft sehen wir Fortschritte auf vielen Bereichen. Nach Bedienung von Handy und PC können bald Datenbanken bearbeitet und Berichte erstellt werden.

Nutzer sind vermehrt bereit, sich diesem Thema zu öffnen, auch wenn Unternehmensanwendungen nicht vorne sichtbar sind.

Q: Wird das Agentenkonzept auf bestehende Betriebssysteme und Geräte angewendet, oder sind neue Hardwareentwicklungen zu erwarten? Wie positioniert sich Zhipu in diesem Szenario?

Zhang Peng: Wir streben eine offene Plattform an, die auf zukünftiges Wachstum abzielt.

Gegenwärtige Systeme und Rechte werden transformiert durch effektivere Ansätze, egalisieren bestehende Lösungen. Auch in neuen Richtungen erfolgen Experimente wie AI Pin und AI Rabbit als künftige Hardwarebeispiele.

Von der KI-Welle wollen wir profitieren, indem zusätzliche Anwendungen beschleunigt werden, und wir tun unseren Teil dazu bei.

Q: Was sind die Kernherausforderungen der großen Modelle, denen man vorausschauend begegnen muss?

Liu Xiao: Scaling Laws bleiben gültig und verzichten nicht ohne weiteres darauf. Unlösbare Probleme sind oft eng gefasste Missverständnisse. Auf Algorithmen und Fortschritte kommen an.

Häufig überschätzen Menschen kurzfristigen Einfluss, während sie das langfristige Potenzial unterschätzen; in kürzester Zeit wird viel verändert.

Willkommen zu Diskussionen

Willkommen zu Diskussionen