Nachdem Sora hervorgetreten ist, wie geht Luma AI mit dem enormen Traffic um? |36Kr-Interview

Autor: Zhou Xinyu

Redaktion: Su Jianxun

Luma AI fordert OpenAI im Videobereich heraus, ähnlich wie Durant, der plötzlich auf Tennis umsteigt und gegen den Grand-Slam-Sieger Nadal gewinnt.

Vor Kurzem hat dieses in 2021 gegründete Silicon-Valley-Unternehmen im Austausch mit „Emerging Intelligence“ den rasanten Erfolg seines Videogenerierungsmodells Dream Machine AI rekapituliert.

Ein Video-Modell zu veröffentlichen, das mit OpenAI Sora mithalten kann, ist für ein Startup kein leichtes Unterfangen – zumal Luma AI im Bereich der Videogenerierung sozusagen „Quereinsteiger“ war:

Noch vor 2024 war das Unternehmen, das sich auf 3D-Generierung konzentrierte, ein kleiner Betrieb mit etwa 10 Mitarbeitern. Barkley Dai, Datenproduktverantwortlicher bei Luma AI, teilte „Emerging Intelligence“ mit, dass das Team erst nach der Entscheidung im Dezember 2023, auf Videogenerierung umzusteigen, um Talente im Videobereich erweitert wurde und die Größe auf 50 Mitarbeiter angewachsen ist.

Er betonte, dass die technische Stärke, das Veröffentlichungstiming und die Betriebsstrategie unentbehrlich waren, damit Luma AI im Bereich der Videoerzeugung so erfolgreich werden konnte.

Die Talente sind laut der Firma das wichtigste Kapital für die Entwicklung von Videomodellen. Nach der Entscheidung im Dezember 2023, von 3D auf Videogenerierung umzustellen, gewann Luma AI 40 Fachkräfte aus dem KI-Bereich hinzu.

Zudem hat Luma AI, um mit OpenAI und Google konkurrieren zu können, viele Optimierungen an den Algorithmen und der Infrastruktur seiner Modelle vorgenommen. Barkley erklärte „Emerging Intelligence“, dass das Team auf der im Sora verwendeten DiT-Architektur basierend, eine eigenständig verbesserte Struktur verwendet hat, die sowohl die Generierungsqualität sicherstellt als auch Trainings- und Inferenzkosten spart.

Die Veröffentlichung von „Dream Machine AI“, am 13. Juni 2024, traf auf ein Marktvakuum im Bereich der Videomodelle – dies verlieh Dream Machine AI eine gewisse Einzigartigkeit, denn neben Kuaishous „Coling“ ist es das einzige echte öffentlich zugängliche Videomodell.

Die „zeitlich begrenzte kostenlose Nutzung“-Strategie des Modells zog zudem sofort eine Masse an Testnutzern an: Innerhalb von 4 Tagen nach dem Start erreichte die Nutzerzahl von Dream Machine AI eine Million. Barkley verriet „Emerging Intelligence“, dass die Marketingkosten von Dream Machine AI bei 0 lagen und allein auf organische Empfehlungen von Meinungsführern und der Mund-zu-Mund-Propaganda der Nutzer beruhte.

Nach dem rasanten Erfolg ist es nun die Aufgabe von Luma AI, die Nutzerbindung zu erhöhen, um den Erfolg nicht nur von kurzer Dauer sein zu lassen.

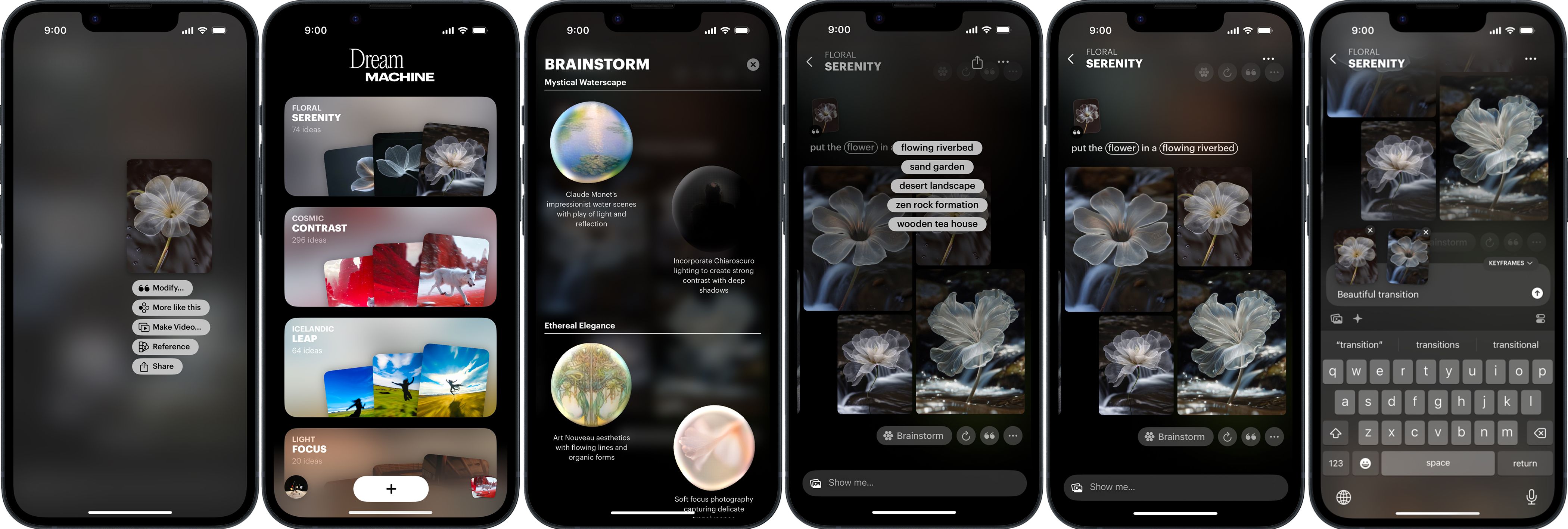

Am 26. November 2024, fast sechs Monate nach der Veröffentlichung des Videomodells, hat Luma AI die Dream Machine AI-Kreativplattform auf iOS und im Web gestartet. Zeitgleich veröffentlichte das Unternehmen auch sein erstes selbst entwickeltes Bildgenerierungsmodell, Luma Photon.

△ Dream Machine iOS-Oberfläche.

Luma AI-Produktdesigner Jiacheng Yang informierte „Emerging Intelligence“, dass Dream Machine im Gegensatz zu professionellen Design-Tools wie Midjourney und Adobe keine Kenntnisse über die Eingabeaufforderung (Prompts) oder Designkenntnisse von den Nutzern verlangt. „Unser Ziel ist ein KI-Visualisierungstool, das sowohl für Anfänger als auch für Designanfänger leicht zugänglich ist.“

Er stellte fest, dass Dream Machine fünf Kernfunktionen hat:

(1) Die Nutzung von natürlicher Sprache, um die Erstellung und Bearbeitung von Bildern zu ermöglichen;

(2) Kreative Ideen von der KI basierend auf den Nutzereingaben vorschlagen zu lassen, sowie Optionen für Stil und Kreativität bereitzustellen;

(3) Visuelle Referenzen zu nutzen, um mithilfe eines vom Nutzer hochgeladenen Fotos Bilder zu erstellen, die entweder dasselbe Motiv oder denselben Stil besitzen;

(4) Von der KI entworfene Bilder in Videos umzuwandeln, damit Nutzer sehen können, wie das Bildmotiv aus verschiedenen Blickwinkeln dargestellt wird;

(5) Alle von der KI generierten Materialien auf dem Panel zu veröffentlichen und einen teilbaren Link zu erstellen, der bei der Teamkoordination zur Ideenfindung hilfreich ist.

△ Dream Machine-Funktion zur visuellen Referenz.

Warum ein Bilddesign-Tool zur Unterstützung der Nutzer des Videomodells wählen? „Für eine breitere Nutzerbasis im Bereich der KI-Visualisierung reicht allein die Videogenerierung nicht aus. Die Anwendungsszenarien für die Bildgenerierung sind vielfältiger, daher wollten wir eine benutzerfreundliche Plattform schaffen, die dazu dient, unsere Modellfähigkeiten zu demonstrieren“, erklärte Barkley.

Der Wettbewerb in der Branche ist eine Herausforderung, der sich Luma AI als Startup stellen muss. Sie sind der Meinung, dass die Differenzierung der Schlüssel ist, um ihre Modelle und Produkte erkennbar zu machen und Kunden zu gewinnen.

Zum Beispiel verbesserte Dream Machine die Sprachverständnisfähigkeiten „bis zum Maximum“, um gegen Midjourney und ähnliche Produkte zu konkurrieren. Zudem ist es ein Modell, das Schriften besser gestaltet – die Designqualität und Klarheit der Texte auf den Dream Machine-Bildern ist im Vergleich zu Midjourney und GPT am besten.

△ Untertitel, die von Dream Machine in das Bild eingefügt wurden.

Genau wie beim Videomodell hat Luma AI für Dream Machine keine Marketingausgaben eingeplant. Laut Barkley ist kostspieliges Marketing an den Return on Investment gebunden, was bedeutet, dass letztendlich das Produkt selbst entscheidend ist. Er stellte zudem fest: „Der KI-Markt ist noch klein, ich glaube, dass es für KI-Unternehmen zu früh für intensive Marketingstrategien ist. Es wäre besser, in die Produktentwicklung zu investieren.“

Bitte finden Sie unten den leicht bearbeiteten Austausch zwischen „Emerging Intelligence“ und Barkley Dai, Leiter des Wachstums bei Luma AI, sowie dem Produktdesigner Jiacheng Yang:

Kostspieliges Marketing: Für KI-Unternehmen noch verfrüht

Emerging Intelligence: Hatte das Team bei der Veröffentlichung des Videomodells Dream Machine im Juni 2024 mit einem solch großen Erfolg gerechnet?

Barkley: Es übertraf tatsächlich unsere Erwartungen. Wir standen vor Herausforderungen bei der Server- und GPU-Ressourcenbewältigung.

Emerging Intelligence: Wenn Sie den Erfolg zusammenfassen müssen, was wäre Ihrer Meinung nach der Grund?

Barkley: Die zunächst veröffentlichte Version war noch nicht die mit den besten Ergebnissen. Aber wir haben uns entschieden, es allen Benutzern kostenlos zur Verfügung zu stellen.

Zu dieser Zeit gab es kein Videomodell, das dies bieten konnte. In der kurzen Zeit zog es daher viel Aufmerksamkeit auf sich.

Emerging Intelligence: War es für ein Startup nicht besonders schwierig, sich für eine kostenlose Bereitstellung zu entscheiden?

Barkley: Tatsächlich haben wir damals eine Begrenzung für die kostenlose Nutzung festgelegt. Ich denke, das ist eine übliche Praxis in der Branche.

Doch der Ansturm in der Spitzenzeit war für uns zu groß, und eine Vielzahl von Nutzern nutzen den Dienst innerhalb kurzer Zeit, was zu einer hohen Zahl an Anfragen im Backend führte.

Emerging Intelligence: Kann das Unternehmen die durch den hohen Traffic verursachten Inferenzkosten stemmen?

Barkley: Wir haben viele technische Optimierungen vorgenommen, etwa dahingehend, die Geschwindigkeit der Videogenerierung zu verbessern. Anfangs benötigte unser Modell 120 Sekunden, um ein fünfsekündiges Video zu generieren, jetzt dauert es nur noch 20 Sekunden.

Und auch, während die ursprüngliche Generierungsqualität beibehalten wird, gibt es noch viele Möglichkeiten zur Optimierung der Videomodell-Inferenz. Daher sind die Kosten für das Videomodell im Halbjahreszeitraum gesunken.

Ich empfinde die Inferenzkosten nicht als große Belastung, sie machen natürlich einen Ausgabenposten aus, werden aber in Zukunft weiter sinken.

Emerging Intelligence: Haben Sie eine Vorstellung davon, wie viele Benutzer nach Erschöpfung der kostenlosen Nutzung bezahlen?

Barkley: Ehrlich gesagt hatten wir keinerlei Erwartungen an die Zahlungsquote. Denn zu der Zeit hatten wir Dream Machine als ein Produkt positioniert, das die Benutzer über das Potenzial der Videogenerierung von Luma AI aufklärt. Zu dieser Zeit gab es noch kein auf Soras Niveau herausgebrachtes Videomodell auf dem Markt, daher hatten wir keinen Maßstab für die Zahlungsquote.

Die nun veröffentlichte AI Design Platform zielt jedoch darauf ab, Kunden zu gewinnen. Daher setzen wir jetzt höhere Erwartungen an den Umsatz und die Zahlungsquote.

Emerging Intelligence: Wie viel hat Dream Machine in Marketing investiert?

Barkley: 0, wir haben keinerlei Marketingkosten eingeplant.

Natürlich haben wir im Vorfeld mit vielen Erstellern Kontakt aufgenommen, die das Produkt nach dem Ausprobieren aufregend fanden. Einige von ihnen hatten zuvor Runway oder Coling genutzt, fanden jedoch, dass unser Produkt „the next big thing“ ist und haben uns auf Twitter freiwillig unterstützt.

Wir haben keine Gebote oder Werbeaktionen gemacht, weil wir weiterhin daran glauben, dass das Erfolgsgeheimnis im Produkt selbst liegt.

Emerging Intelligence: Ist kostspieliges Marketing ein häufiges Vorgehen bei AI-Unternehmen im Silicon Valley?

Barkley: Meines Erachtens sind die meisten im Silicon Valley stark produktorientiert, die Betriebsmethoden sind eher in chinesischen Unternehmen gebräuchlich.

Der Markt im visuellen Bereich ist noch klein. Ich glaube, dass kostspieliges Marketing für AI-Unternehmen noch zu früh ist. Auch wenn ChatGPT zahlreiche Nutzer hat, sind die Nutzer von visuellen Modellen immer noch eine kleine Minderheit.

In diesem Stadium erreichen kostspielige Werbung und Marketing nicht die gewünschte Nutzerbindung; es wäre daher besser, diese Ressourcen in die Weiterentwicklung der Modelle und Produkte zu stecken, um mit besseren Angeboten Nutzer zu gewinnen.

Emerging Intelligence: Bevor Luma AI das Videomodell veröffentlichte, war die Technik und die Produktentwicklung hauptsächlich auf 3D-Generierung fokussiert. Wann entschied sich das Team, ein Videomodell zu entwickeln?

Barkley: Ungefähr im Dezember 2023.

Emerging Intelligence: Warum der Wechsel von 3D zu Video- und Bildmodellen?

Barkley: Ursprünglich haben wir uns nicht als reines 3D-Unternehmen verstanden; die Ausrichtung der Firma verblieb weiterhin im Bereich der visuellen KI-Technologie, mit dem Ziel, die visuelle Konstruktion der Welt besser zu verstehen und AI dabei zu helfen, diese Welt zu erfassen.

Wenn man sich den Forschungs- und Hintergrund der Gründer anschaut, war 3D anfangs etwas, worin Luma AI nahezu allen anderen Unternehmen und Teams überlegen war. Später haben wir auch zahlreiche technische Durchbrüche in der 3D-Generierung erzielt.

Allerdings sind die verfügbaren Datenmengen zur Schulung von 3D- im Vergleich zu Bild- und Video-Modellen wesentlich geringer. Zudem sind die Nutzungsszenarien aufgrund der hauptsächlich auf mobilen Geräten und Computern basierenden heutigen Produktumgebungen, für 3D Anwendungen stark eingeschränkt.

Doch als wir über mehr Rechenkapazitäten, mehr Talente sowie mehr Fähigkeiten verfügten, um unser Ziel zu fördern – die Welt besser zu verstehen – entschieden wir natürlich, von 3D auf Videoerstellung umzusteigen.

Emerging Intelligence: Macht das den Eindruck, als ob die Unternehmensstrategie schwankend sei?

Barkley: Aus der Perspektive eines internen Mitarbeiters empfinde ich die Entwicklung sowohl im 3D- als auch im Videobereich als logisch.

Denn obgleich es sich um 3D, Video oder Bild handelt, können all diese Möglichkeiten als Modalitäten bezeichnet werden. Wenn das letztendliche Ziel darin besteht, die Welt zu verstehen, dann sind diese Modalitäten, diese Generierungen, oder kreativen Ausdrücke lediglich die Mittel zum Zweck, um das Ziel zu erreichen.

Emerging Intelligence: Welche Schwierigkeiten traten während des Übergangs von 3D zur Videogenerierung auf?

Barkley: Der ganze Prozess verlief glatt, denn als wir mit der 3D-Generierung arbeiteten, war unser Team noch im Kern 10 bis 15 Mitglieder stark, doch mit der Umstellung auf Videogenerierung begannen wir, insbesondere Talente aus dem Videobereich hinzuzufügen – inzwischen ist das Team auf mehr als 50 Menschen angewachsen.

Es war mehr ein Prozess des Gewinnens neuer Mitglieder, um damit das Ziel zu erreichen, anstatt Richtungen häufig zu ändern. Diejenigen, die vorher im 3D tätig waren, begannen allmählich auch im Videobereich zu arbeiten, etwa auf Datenseite.

Emerging Intelligence: Hilft die Erfahrung in der 3D-Generation bei der Videogenerierung? Viele meinen, die Bewegungsverläufe bei Dream Machine seien besonders gut gelungen. Hat das mit der räumlichen Verständnisfähigkeit aus der 3D-Erfahrung zu tun?

Barkley: Ich glaube nicht, dass die Beziehung so direkt ist.

Doch schon bei der Veröffentlichung unserer ersten Videomodellversion fokussierten wir uns stark auf die Kamerawege, einschließlich der Wechsel der Perspektiven innerhalb des Videos.

Daher war das Feedback auch, dass das Modell von Luma AI, trotz gelegentlich instabiler Ergebnisse, umfassende Kamerabewegungen und komplexe Bewegungsverläufe von Figuren liefern kann.

Ich denke, unsere Erfahrungen im 3D-Bereich haben es uns dabei ermöglicht, bei der Erstellung visueller Modelle mehr Wert darauf zu legen, die Vielfalt der Kameraeinstellungen und die Komplexität der Bewegungsverhältnisse zu verbessern, wodurch sich die Bereitschaft der Nutzer, den generierten Videoinhalt zu konsumieren, erhöht.

Ich glaube jedoch, dass die früheren Erfahrungen sowie die Modelle nicht so stark miteinander verbunden sind oder gegenseitig Bedeutung haben.

Emerging Intelligence: Würden Sie also sagen, dass die Ergänzung neuer Technologien beim Technologiewandel am wichtigsten ist?

Barkley: Genau.

Modelle sollten von passenden Produkten begleitet werden

Emerging Intelligence: Nachdem Dream Machine im Juni populär wurde, wie plante das Team, die Nutzerbindung sicherzustellen?

Barkley: Uns war klar, dass wir nach der Veröffentlichung von Dream Machine ein Produkt benötigen würden, um die kontinuierlichen Bedürfnisse der Nutzer zu befriedigen.

Wenn Sie zum Beispiel ein langfristiger Nutzer von ChatGPT sind, greifen Sie wahrscheinlich eher auf ChatGPT zurück, auch wenn später Modelle auftauchen, die ähnliche Fähigkeiten bieten. Denn ChatGPT hat durch langfristiges Lernen Nutzergewohnheiten verstanden und ist in der Lage, Ihre Absichten besser zu interpretieren.

Es wird immer bessere Modelle in der Branche geben, aber Produkte sind letztendlich der Punkt, der die Nutzerbindung aufrechterhält.

Emerging Intelligence: Wann begann das Team mit der Planung dieser AI-Designplattform?

Barkley: Diese Idee bestand tatsächlich schon, als wir mit der Entwicklung des Videomodells begannen. Die Konzeptentwicklung für das Produkt begann somit im Dezember letzten Jahres (2023) parallel zur Entwicklung des Videomodells.

Allerdings wurde uns im Laufe des Produktentwicklungsprozesses bewusst, dass wir für eine umfassende Abdeckung des gesamten Designprozesses auch in der Lage sein mussten, Bilder zu generieren. Deshalb haben wir die beiden Bereiche erst fünf Monate nach der Veröffentlichung des Videomodells integriert, als wir das Gefühl hatten, dass auch das Bildmodell ausreichend ausgereift war.

Emerging Intelligence: An wen richtet sich die Plattform? An professionelle Designer oder die breite Öffentlichkeit?

Barkley: Wir sind der Meinung, dass die ursprüngliche Nutzerbasis von Dream Machine tendenziell professioneller war, zumindest mit AI-Filmerfahrung oder Kenntnisse, wie man Prompts verwendet, um bessere Ergebnisse zu erzielen.

Wir hoffen jedoch, dass wir mit dem neuen Produkt Menschen ansprechen, die bisher keine KI oder Design-Erfahrung haben. Falls sie diese Art von Workflow in ihrer Arbeit benötigen, können sie dies einfach durch eine iterative Konversation mit der KI erreichen.

Das Videomodell Dream Machine, das wir im Juni veröffentlicht haben, erforderte dennoch gewisses Erfahrungswissen. Wir hegten den Wunsch, dass normale Menschen unkomplizierten Zugang zu solchen visuellen Tools haben können, ähnlich wie GPT für Sprache.

Da der visuelle Bereich ein Nischenbereich ist, war unsere Designplattform-Idee, wie wir diese Zielgruppe vergrößern. Nur durch die Ausweitung der Nutzerbasis kann das visuelle AI-Feld besser gedeihen.

Emerging Intelligence: Dass nicht-professionelle Designer tief in eine vollständige Design-Workflow integrieren, fällt ihnen schwer. Mein Bedarf für generierte Bilder kann oft einfach mit einem Prompt durch GPT oder Midjourney gedeckt werden.

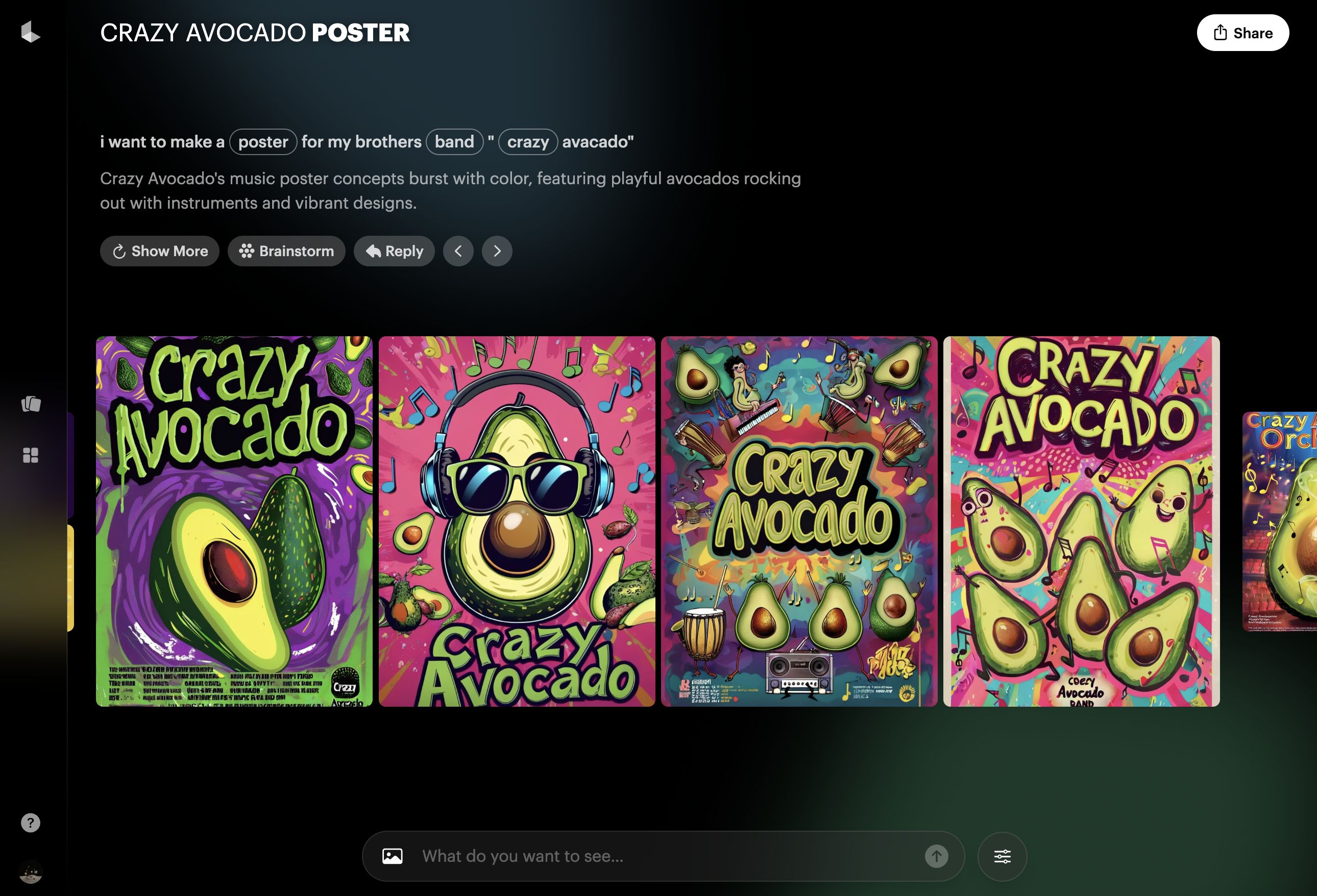

Jiacheng: Unsere Idee ist, die Funktionen, bei denen Nutzer den Unterschied spüren, am besten auszubauen – so ist unsere Bildverarbeitungsfähigkeit besser als GPT, während unsere Sprachverständnisfähigkeiten Midjourney übertreffen.

Ich habe einen simplen, unverfälschten Prompt verwendet, um Dream Machine und Midjourney zu testen: i want to make a poster for my brother band „crazy avocado“.

△ Dream Machine hat ein Poster für die Band „crazy avocado“ erstellt.

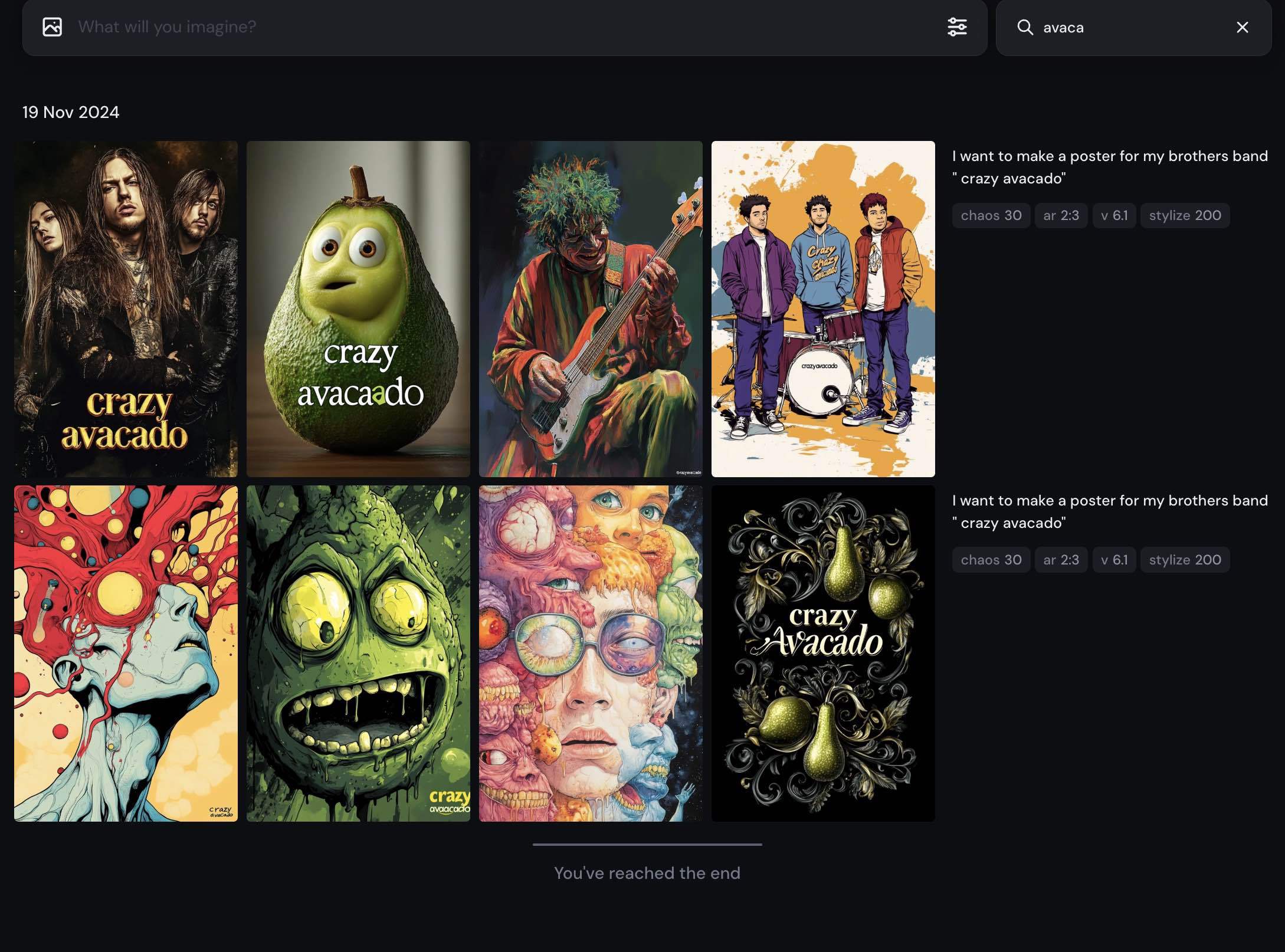

△ Midjourney hat ein Poster für die Band „crazy avocado“ erstellt.

Sie sehen, das Midjourney-Plakat ist weder „crazy“ noch hat es „avocado“-Elemente, und es ist auch nicht offensichtlich, dass es ein Bandposter ist.

Das semantische Verstehen ist wichtiger, als man denkt, es beeinflusst viele Anwendungsfälle. Zufällige, hübsche Bilder zu generieren, ist im praktischen Umfeld nicht besonders hilfreich.

Um dasselbe Ergebnis mit Midjourney zu erzielen, muss man viele Prompts beschreiben, etwa das Plakatdesign, den Text darauf oder den Stil von „crazy“. Prompt-Schreiben zu lernen, dauerte bei mir etwa zwei bis drei Monate.

Aber ich glaube, dass die meisten ChatGPT-Nutzer sich dafür nicht die Zeit nehmen, sie möchten einfach eine Frage stellen und eine Antwort erhalten.

Unser Designproduktansatz ist ähnlich. Bei bisherigen Produkten auf dem Markt – wenn ich ein Bild generieren will, das meine Intentionen wiedergibt, müsste ich zuerst 20 Dollar für Claude oder GPT ausgeben, um Prompts zu erstellen. Dann würde ich 20 bis 40 Dollar für Midjourney zahlen, um das Bild zu generieren, und noch einmal 20 Dollar für ein Abonnement zahlen, um diese Bilder in Videos zu verwandeln.

Insgesamt würde das Text-zu-Video-Erstellen mindestens 60 bis 80 Dollar kosten. Mit Dream Machine könnte man das möglicherweise für 10 Dollar schaffen.

Emerging Intelligence: Stammt die Sprachverständnisfähigkeit von Dream Machine auch aus einem selbst entwickelten Modell?

Barkley: Für das Sprachmodell verwenden wir eine API von Drittanbietern, auf der wir dann einen Agenten aufgebaut haben. Dieser Agent kann Nutzerintentionen verstehen und sie mithilfe verschiedener Anweisungen in Anweisungen umwandeln, die Bild- und visuelle Modelle verstehen können.

Emerging Intelligence: Wie plant Luma AI, sowohl das Modell als auch das Produkt zu monetarisieren?

Barkley: Das Produkt wird über ein Abonnement-Modell angeboten. Für das Modell bieten wir eine API an.

Emerging Intelligence: Keine Anpassung?

Barkley: Anpassung ist für Startups nicht geeignet, da sie von den Kernaufgaben ablenkt.

Derzeit gibt es kein professionelles Visualisierungstool, das eine Interaktionsnorm definiert

Emerging Intelligence: Eine bekannte Frage: Wie sehen Sie den Einstieg der großen Unternehmen? Im Inland hat das Engagement von ByteDance und Kuaishou bereits den Druck auf viele Startups in der Kapitalbeschaffung und Kundengewinnung erhöht.

Barkley: Wir stellen fest, dass diese Frage eher Unternehmen und ihre Aktionäre betrifft. Lediglich Aktionäre sind besorgt darüber, was passiert, wenn eines Tages ein Riese dasselbe Vorhaben umsetzt.

Tatsächlich fühlen sich viele Forscher in unserer Firma so: Wenn ein Unternehmen eine gewisse Größe erreicht und verschiedene Koordinationen erforderlich sind, verlangsamt sich der Fortschritt dramatisch, und die Innovationsrate nimmt ab.

Obwohl das Luma AI-Team in den letzten eineinhalb Jahren stark gewachsen ist, beibehalten wir ein schnelles Innovationstempo und eine schnelle Iteration.

Es gibt einen treffenden Vergleich: Bei großen Unternehmen arbeiten nur einige Dutzend Menschen tatsächlich an den Videomodellen und entsprechenden Produkten. Zum Beispiel wirkt OpenAI riesig, aber das Sora-Team ist begrenzt.

Sicherlich verfügt ein größeres Unternehmen wie Google über bessere Vertriebskanäle, wird jedoch auch durch verschiedene Prozesse beeinträchtigt, da etwa die Kommerzialisierung eines neuen Produkts viele Bedenken mit sich bringt, sodass es nicht schnell weiterverfolgt wird.

Emerging Intelligence: Wie schnell ist das Iterationstempo von Luma AI?

Barkley: Die Gesamtiterationsgeschwindigkeit wird in Monaten oder sogar 1-2 Monaten gemessen. Im Laufe der Zeit werden neue Funktionen hinzugefügt und basale Modellfunktionen verbessert.

Zum Beispiel wurde Dream Machine 1.0 im Juni 2024 veröffentlicht, Version 1.5 folgte im August. Die Version 1.6 enthielt die Kamera-Steuerung und wurde Ende September veröffentlicht.

Emerging Intelligence: Wie akquiriert man Kunden für ein neues, auf Design-Tools ausgerichtetes Produkt?

Jiacheng: Ich denke, man sollte sich erst einmal ansehen, wie ChatGPT Kunden akquiriert hat. Man stellt fest, dass ChatGPT nicht nur von den besten Programmierern verwendet wird, sondern dass auch die Mütter und Väter in der Nachbarschaft darauf zurückgreifen.

Ich denke, dass AI-Tools eine der bedeutendsten Veränderungen darstellen, da sie durch ihre Flexibilität und Anpassungsfähigkeit für fast jeden mit visuellen Anforderungen genutzt werden können.

Ich sehe nicht, dass derzeitige spezifische visuelle Fachsoftware besonders gute Interaktionen bieten, mit anderen Worten, es gibt derzeit kein professionelles Visualisierungstool, das die Interaktionsnorm für die Branche definiert.

Emerging Intelligence: Wie definieren Sie „eine gute Interaktionsnorm“?

Jiacheng: Beispielsweise hat ChatGPT die Interaktionsnorm für ChatBot in der gesamten Branche gesetzt, das wird mittlerweile sogar von amerikanischen Kindern erzählt: „Hast du deinen 'Chat' zuhause benutzt?“

Das „Chat“ ist zu einem Verhalten geworden, wie es das „Googele es“ ist.

Unser Ansatz bei Dream Machine ist derselbe. Wer es schafft, die Vorstellungen des Durchschnittsbürgers mit einem fließenden, einfachen Ansatz darzustellen – in Form eines attraktiven, unterhaltsamen und teilbaren oder nützlichen Bildes – der wird in diesem Bereich einen Vorteil haben.

Emerging Intelligence: Welche Erkundungen hinsichtlich der Interaktionsformen wurden während der Entwicklungsphase bis zur Veröffentlichung durchgeführt?

Jiacheng: Derzeit sind sowohl wir als auch die Branchenwahrnehmung auf uns als ein Unternehmen für Videomodellforschung ausgerichtet.

Doch die heutigen AI-Technologien sind so stark auf die Benutzererfahrung konzentriert, dass das Ziel und der Iterationsprozess technikbasierter Produkte ganz klar die beste Benutzererfahrung bieten wollen.

Unsere Vision bestand darin, die Dream Machine als kreativen Assistenten oder Creative Partner zu etablieren. Man interagiert mit dem System, wie man auch mit einem Designer interagieren würde.

Mit dieser Zielsetzung untersuchten wir die Möglichkeiten, die unsere Bild- und Videomodelle bieten. Zugleich ermittelten wir den Fortschritt der Branche allgemein, und welche nützlichen Beiträge Drittanbieter-Sprachmodelle liefern könnten.

Zwischenzeitlich entwickelten sich verschiedene Agenten-Software-Tools, und die Überlegungen zur Anwendung von AI veränderten sich. Das führte dazu, dass wir uns während eines Jahres kontinuierlich weiterentwickeln und unser Produkt an Industrieentwicklungen anpassen – durch monatliche Überarbeitungen gemäß Veränderungen in der Industrie.

All diese Elemente wurden harmonisiert und integriert, was letztendlich zu dem Resultat führte, das wir heute haben.

Barkley: Zwischenzeitlich bemerkten wir, dass im Bereich der AI-Videogenerierung, Bild-zu-Video derzeit gegenüber Text-zu-Video bevorzugt wird, da die Benutzer die Kontrolle schätzen.

Daher basieren alle Funktionen darauf, die Benutzerkontrolle zu erhöhen – dies ist eine Kernanforderung.

Emerging Intelligence: Welche branchenspezifischen Produkte oder Trends beeinflussen die Produktentwicklung des Unternehmens?

Barkley: Ich denke, dass unsere Produktstrategie im vergangenen Jahr relativ beständig ist – wir wollen weiterhin Produktlösungen schaffen, die jedermann die einfache Nutzung unserer Modelle ermöglichen, ohne auf Schritte von Dritten angefragt zu sein.

Unser Produktteam konzentriert sich mehr auf Forschungstrends und Fortschritte, etwa im Bereich der Stilumwandlung und -übertragung. Dann prüfen wir die neuesten themenbezogenen wissenschaftlichen Arbeiten und Studien und sogar Produktteams beteiligen sich an den Forschungsgesprächen, um die technische Machbarkeit neuer Funktionen zu ermitteln.

Emerging Intelligence: Wie kommuniziert das Produktteam im Alltag mit dem Algorithmusteam?

Barkley: Bei der Initiierung eines Projekts überlegen wir uns aus Sicht des Benutzers, ob Stilübertragung ein wesentliches Merkmal ist.

Aus der Sicht der Forschung gibt es jedoch Unklarheiten, ob diese Funktionen realisierbar sind und welche Wirkung sie erzielen könnten. Daher führt die Forschung zunächst verschiedene Experimente durch. Sobald eine signifikante Grundierung erzielt wird und das Team die Grenzen der Funktion erkennt, implementieren wir sie in das gesamte Produkt und die Nutzererfahrung.

Zugleich ist die Forschung jedoch ein weitaus unsicherer Prozess, der häufig längere Zeiträume erfordert. Man weiß nicht, wie viel Zeit das Training in Anspruch nehmen wird.

Emerging Intelligence: Wird dabei auf Funktionen verzichtet, die kurzfristig nicht ausgereift genug sind?

Barkley: Genau. Daher denken wir viele Funktionen aus Benutzersicht – einige kann das Forschungsteam in kurzer Zeit umsetzen; für andere investieren wir weiterhin, um längerfristig zu evaluieren und sie dann in zukünftige Produkte zu integrieren.

Wir laden herzlich zum Austausch ein!

Wir laden herzlich zum Folgen ein!