Der OpenAI-Präsident verriet, dass GPT-5 das Inferenzparadigma geändert hat und die Verwirklichung von AGI von realen Rückmeldungen abhängt.

Der Weg von OpenAI hin zu AGI wurde vom Präsidenten Greg Brockman in einem neuesten Interview klar gemacht:

Technisch gesehen geht es von der Textgenerierung hin zu einem Schlussfolgerungsparadigma der Verstärkungslernens, durch Fehlertests in der realen Welt und das Erhalten von Rückmeldungen.

Bei der Ressourcenstrategie geht es darum, kontinuierlich in umfangreiche Rechenressourcen zu investieren.

Beim Implementierungsschritt wird das Modell als Agent verpackt, und die Fähigkeiten des Modells werden zu einem prüfbaren Dienstprozess zusammengefasst.

Dieses Interview wurde vom AI-Podcast Latent Space moderiert, in dem mit Brockman über die gesamte technische Route und die Ressourcenstrategie von OpenAIs AGI diskutiert wurde.

Zur gleichen Zeit kamen auch die Implementierungspläne von OpenAI und Brockmans Gedanken über die Zukunft im Laufe des Interviews ans Licht.

Zusammengefasst hat Brockman diese Kernaussagen gemacht:

Das Modell verbessert ständig seine Fähigkeit zur Interaktion mit der realen Welt, was auch ein Schlüsselbestandteil der nächsten Generation von AGI ist.

Die Hauptschranke für AGI liegt in der Rechenleistung. Die Menge der Rechenleistung bestimmt direkt die Geschwindigkeit und Tiefe der AI-Forschung und -Entwicklung.

Das eigentliche Ziel von AGI ist es, dass das Large Model in den Arbeitsabläufen von Unternehmen und Privatpersonen dauerhaft verweilt, und das Mittel dazu ist der Agent.

Es ist von großem Wert, das Modell in Anwendungsbereiche der realen Welt einzubinden. In allen Bereichen gibt es noch viele unerntete Früchte.

Der Wandel des Schlussfolgerungsparadigmas des Modells

Beim Gepräch über das kürzlich von OpenAI veröffentlichte GPT-5 hält Brockman dies für einen wichtigen Paradigmenwechsel im Bereich der Künstlichen Intelligenz. Als das erste Hybridmodell von OpenAI soll es die Lücke zwischen der GPT-Serie und AGI schließen.

Nachdem GPT-4 trainiert war, stellte sich OpenAI eine Frage:

Warum ist es keine AGI?

Obwohl GPT-4 kohärente Dialoge im Kontext führen kann, ist seine Zuverlässigkeit mangelhaft. Es kann Fehler machen und sogar aus dem Ruder laufen.

Deshalb wurde ihnen bewusst, dass sie ihre Ideen in der realen Welt testen und durch Verstärkungslernen Rückmeldungen erhalten müssen, um die Zuverlässigkeit zu verbessern.

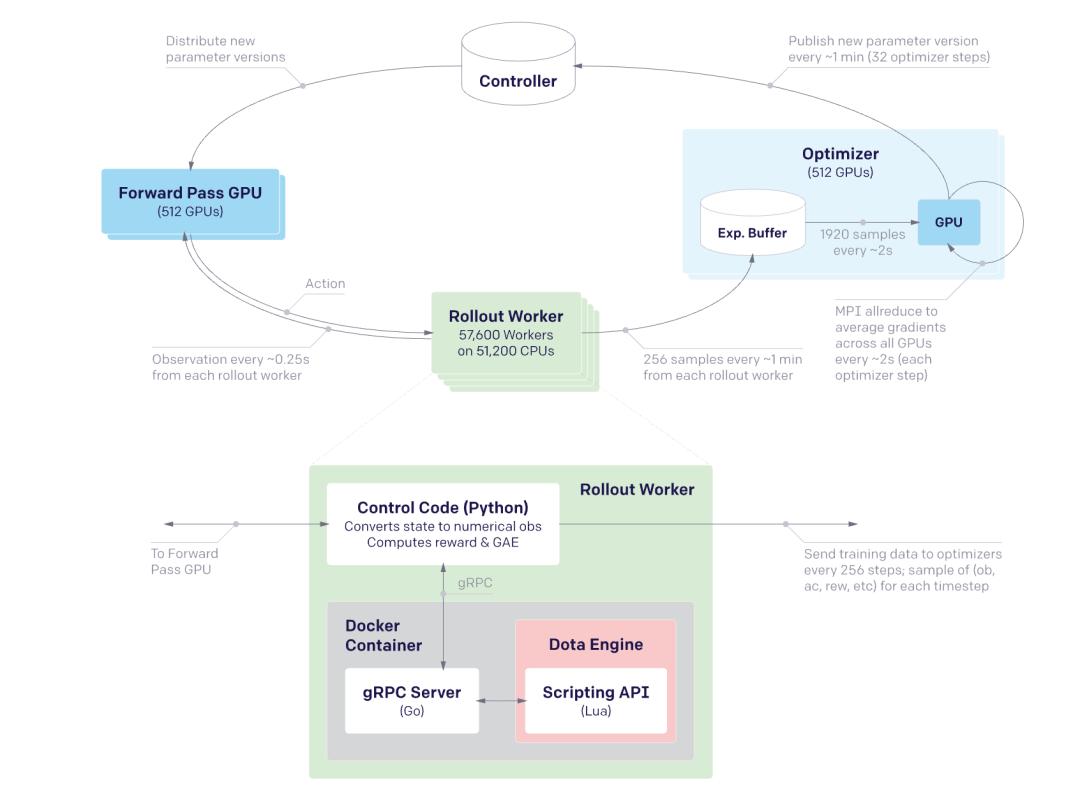

Dies wurde bereits im frühen Dota-Projekt von OpenAI umgesetzt. Damals wurde reines Verstärkungslernen verwendet, mit dem es möglich war, komplexe Verhaltensweisen aus einem zufällig initialisierten Zustand zu lernen.

△

Also begann OpenAI ab dem Moment, als GPT-4 fertig war, einen neuen Ansatz zu verfolgen, nämlich zunächst das Modell durch überwachte Daten im Dialogieren zu schulen und dann mithilfe von Verstärkungslernen wiederholt in der Umgebung Fehler zu machen und daraus zu lernen.

Beim traditionellen Modelltraining wird das Modell einmal trainiert und dann viele Male inferiert. GPT-5 hingegen nutzt das Verstärkungslernen, um dem Modell zu ermöglichen, während des Inferenzprozesses ständig Daten zu generieren und dann auf der Grundlage dieser Daten erneut zu trainieren. Die Beobachtungen aus der realen Welt werden in das Modell zurückgespeist.

Dieser neue Ansatz ändert die erforderliche Datenmenge. Früher benötigte das Vortraining vielleicht Hunderttausende von Beispielen, während beim Verstärkungslernen nur 10 bis 100 Aufgaben benötigt werden, um komplexe Verhaltensweisen zu lernen.

Das zeigt auch, dass das Modell ständig seine Fähigkeit zur Interaktion mit der realen Welt verbessert, was ein Schlüsselbestandteil der nächsten Generation von AGI ist.

Die Rechenleistung bestimmt die Obergrenze der AGI-Entwicklung

Als Brockman gefragt wurde, was die Hauptschranke bei der gegenwärtigen AGI-Entwicklung sei, antwortete er klar: Rechenleistung.

Er meint, dass OpenAI immer einen Weg finden kann, das Modell zu verbessern, solange es mehr Rechenleistung hat. Die Menge der Rechenleistung bestimmt direkt die Geschwindigkeit und Tiefe der AI-Forschung und -Entwicklung.

Beispielsweise wurde im Dota-Projekt allgemein angenommen, dass der PPO (Proximal Policy Optimization)-Algorithmus nicht skalierbar sei. Doch indem sie die Anzahl der Kerne verdoppelten, konnten sie eine kontinuierliche Leistungssteigerung erzielen. Das heißt, die sogenannten Algorithmusbarrieren können durch die Erhöhung der Rechenressourcen überwunden werden.

Das Verstärkungslernparadigma von GPT-5 bringt zwar eine höhere Stichprobeneffizienz, aber es erfordert dennoch, dass das Modell Tausende von Versuchen unternimmt, um eine Aufgabe zu lernen. Dies erfordert eine enorme Rechenleistung.

Darüber hinaus hat Turing das Konzept der „superkritischen Lernens“ für AGI vorgeschlagen. Er meint, dass Maschinen nicht nur lernen sollen, was ihnen direkt beigebracht wird, sondern auch über die sekundären, tertiären und sogar quartären Effekte nachdenken und ihr gesamtes Wissenssystem aktualisieren sollen.

Dieser tiefere Lernprozess erfordert ebenfalls mehr Rechenressourcen. Das aktuelle Ziel von OpenAI ist es, zu untersuchen, wie man die Rechenleistung kreativer nutzen kann, um diese fortschrittliche Lernfähigkeit zu erreichen.

Brockman beschreibt die Rechenleistung als einen grundlegenden Brennstoff, der Energie in potentielle Energie umwandeln kann, die in den Gewichten des Modells gespeichert wird, um das Modell zu veranlassen, effektive Aktionen auszuführen.

Sobald das Modell durch umfangreiche Berechnungen trainiert ist, kann es wiederholt genutzt werden, und die hohen Rechenkosten können auf mehrere Aufgaben verteilt werden.

Außerdem sagt er voraus, dass die endgültige AGI letztendlich ein Modellmanager sein wird, der kleine lokale Modelle mit großen Cloud-Inferenzern kombiniert, um adaptive Rechenleistung zu erreichen.

Der Mechanismus der Hybridisierung und des Routings von mehreren Modellen in GPT-5 ist ein erster Versuch in dieser Richtung. Es kombiniert Inferenzmodelle mit Nicht-Inferenzmodellen und wählt mithilfe von bedingten Anweisungen das geeignete Modell aus.

Inferenzmodelle eignen sich besser für Szenarien mit tiefer Intelligenz und ausreichender Zeit zum Nachdenken, während Nicht-Inferenzmodelle für schnelle Output-Runden verwendet werden.

Dieses zusammengesetzte Modell nutzt die Flexibilität der Rechenleistung voll aus. Es kann Modelle mit verschiedenen Fähigkeiten und Kosten je nach Aufgabenstellung kombinieren und ist wahrscheinlich die Form, in der AGI am ehesten auftreten wird.

Deshalb wird in der zukünftigen AI-getriebenen Wirtschaft die Rechenleistung zu einer Ressource mit hohem Bedarf. Forscher mit mehr Rechenressourcen können bessere Ergebnisse erzielen. Die Frage, wie man an Rechenressourcen kommt und wie diese verteilt werden, wird sehr wichtig sein.

Das Large Model in die Produktion bringen

Brockman betont wiederholt, dass das Modell nicht mehr nur ein Forschungsobjekt ist, sondern ein Teil der realen Produktionslinie werden soll.

Er weist darauf hin, dass das eigentliche Ziel von AGI darin besteht, dass das Large Model in den Arbeitsabläufen von Unternehmen und Privatpersonen dauerhaft verweilt, anstatt nur in Papieren und Demonstrationen zu existieren.

Der konkrete Implementierungsweg besteht darin, das Modell als Agent zu verpacken und die Fähigkeiten des Modells zu einem prüfbaren Dienstprozess zusammenzufassen.

Brockman meint, dass diese Interaktion wie die Zusammenarbeit mit einem erfahrenen Kollegen ist. Ein Schlüsselfaktor ist die Kontrollierbarkeit – man kann es „jederzeit anhalten und überprüfen lassen“ und jeder Schritt kann rückgängig gemacht werden.

Um die Kontrollierbarkeit von Agenten mit hoher Berechtigung sicherzustellen, hat OpenAI eine zweischichtige Struktur der „graduellen Abwehr“ entworfen:

Innerhalb des Modells werden die Anweisungen von System, Entwickler und Benutzer nach ihrer Vertrauenswürdigkeit geordnet, so dass Anweisungen wie „alle vorherigen Anweisungen ignorieren“ bereits in der ersten Stufe verworfen werden.

Außerhalb des Modells werden alle potenziell gefährlichen Aktionen in die kleinsten Einheiten zerlegt und über mehrere Stufen von Sandboxen einzeln bestätigt.

Für diesen Ansatz macht Brockman einen Vergleich mit der Datenbanksicherheit:

Genau wie beim Schutz vor SQL-Injection muss man zunächst die Löcher in der untersten Ebene schließen und dann die Schutzmechanismen hinzufügen. Dann wird das System von selbst stabil.

Außer den Sicherheitsmechanismen ist auch die Ausrichtung der Werte mit den Menschen ein wichtiges Projekt.

Das Ingenieurteam entfernt zunächst durch Nachtraining die allgemein unbeliebten Typen aus den unzähligen potenziellen „Persönlichkeiten“.

Anschließend werden die verbleibenden „Persönlichkeiten“ in einer öffentlichen Arena bewertet. Strategien mit hoher Bewertung werden in der nächsten Runde verstärkt, während solche mit niedriger Bewertung geschwächt werden. So entsteht eine ko-evolutionäre Beziehung zwischen dem Modell und den gesellschaftlichen Präferenzen.

Dieser Prozess stellt sicher, dass das Modell beim Leistungsupgrade nicht von den menschlichen Konsens abweicht und legt auch die Datenbasis für das zukünftige Online-Lernen.

Außerdem hat OpenAI die leichte Open-Source-Strategie als zweiten Antrieb festgelegt, um die Ökosystembindung zu stärken.

Brockman glaubt, dass Entwickler, die Werkzeugketten auf diesen Modellen entwickeln, in der Tat die Technologie-Stack von OpenAI akzeptieren.

„In allen Bereichen gibt es noch viele unerntete Früchte“

Auf die Zukunft blickend meint Brockman, dass die wirklich lohnenswerten Chancen nicht darin liegen, einen noch aufwendigeren „Modellwrapper“ zu schaffen, sondern darin, die vorhandene Künstliche Intelligenz in die realen Prozesse der konkreten Branchen zu integrieren.

Viele Menschen meinen, dass alle guten Ideen schon ausgearbeitet seien. Aber er warnt, dass jede Branchenkette ungeheuerlich umfangreich ist.

Es ist von großem Wert, das Modell in Anwendungsbereiche der realen Welt einzubinden. In allen Bereichen gibt es noch viele unerntete Früchte.

Deshalb rät er Entwicklern und Unternehmern, die „zu spät am Start“ glauben, zunächst in die Branche einzutauchen, die Interessengruppen, die Vorschriften und die Details der bestehenden Systeme zu verstehen und dann mit AI die echten Lücken zu schließen, anstatt nur einmalige Schnittstellen zu entwickeln.

Als man ihn fragte, was er sich auf einen Zettel für sich selbst von 2045 schreiben würde, nannte er „Multi-planetares Leben“ und eine „wirkliche reiche Gesellschaft“ als seine Vision.

Nach seiner Meinung ist es angesichts der gegenwärtigen technologischen Beschleunigung schwer, die Machbarkeit fast aller Science-Fiction-Szenarien in 20 Jahren zu leugnen. Die einzige harte Beschränkung ist die physikalische Grenze des materiellen Transports.

Zur gleichen Zeit warnt er auch, dass Rechenressourcen zu einem knappen Gut werden. Selbst wenn die materiellen Bedürfnisse durch