OpenAI veröffentlicht das neueste Videomodell Sora Turbo, für Mitglieder kostenlos nutzbar, die Website ist überlastet.

Artikel zuerst veröffentlicht auf der WeChat-Öffentlichkeitsnummer "Intelligente Erscheinung"

Text | Tian Zhe

Bearbeitung | Su Jianxun

In den frühen Morgenstunden des 10. Dezember hat OpenAI die High-Speed-Version des Videomodells Sora — Sora Turbo — offiziell vorgestellt, die im Vergleich zur ersten Generation von Sora Videos schneller generiert.

Es wird berichtet, dass die erste Generation von Sora von OpenAI durchschnittlich 10 Sekunden für die Generierung einer Sekunde Video benötigt, während bei einer Live-Demonstration gleichzeitig vier 10-Sekunden-Videos in nur 72 Sekunden erstellt wurden.

Gleichzeitig kann Sora Turbo Videos aus Text/Bildern/Videos zu niedrigeren Kosten generieren.

Ab sofort sind alle Funktionen von Sora Turbo für Mitglieder von OpenAI Plus und Pro ohne zusätzliche Gebühren verfügbar, jedoch mit unterschiedlichen Nutzungskontingenten für verschiedene Mitgliedertypen:

OpenAI Plus-Mitglieder, die monatlich 20 US-Dollar zahlen, haben 50 Video-Generierungen pro Monat; Pro-Mitglieder, die monatlich 200 US-Dollar zahlen, können Videos unbegrenzt langsam generieren, beschleunigt 500-mal pro Monat, wobei bei der Generierung hochauflösender Videos die Verfügbarkeit eingeschränkt ist.

Auch die Video-Generierung unterscheidet sich. Plus-Mitglieder können Videos mit einer maximalen Auflösung von 720p und einer Dauer von 5 Sekunden erstellen; Pro-Mitglieder können gleichzeitig 5 Videos mit einer Auflösung von 1080p und einer Dauer von bis zu 20 Sekunden generieren.

Laut OpenAI-Website ist Sora in 155 Ländern und Regionen weltweit nutzbar, ausgenommen sind Festlandchina und die meisten europäischen Regionen.

Mit der Freigabe von Sora führte ein Ansturm von Nutzern zu überlasteten Servern. In Bezug auf diese Situation erklärte OpenAI-Gründer und CEO Sam Altman, dass die Nutzerregistrierung geschlossen wurde und die Video-Generierung für eine Weile langsamer sein wird.

Quelle: X

Ein Leitfaden für Online-Video-Tools

Das OpenAI-Team definiert Sora als kreatives Tool, das Nutzern erlaubt, ein gewünschtes Video aus einer Textbeschreibung, einem Bild oder einem Video zu generieren.

Sie erwähnten, dass Sora keinen Spielfilm auf Knopfdruck generieren kann, sondern ständige Optimierung erfordert. Um Sora anschaulich vorzustellen, wurde die Sora-Einführungsveranstaltung von OpenAI zu einem Tutorial für Online-Video-Tools.

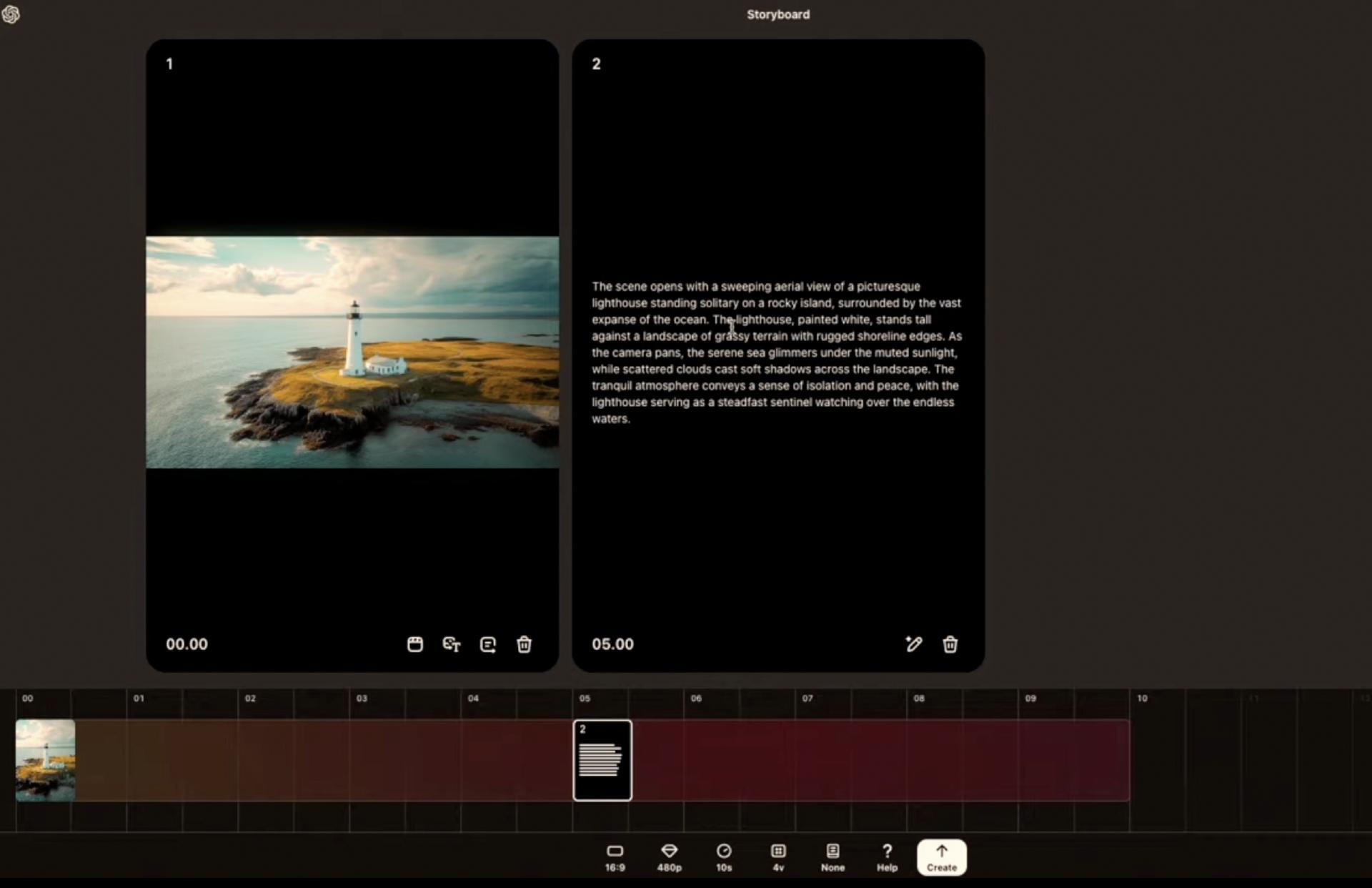

Wenn Nutzer ein Video generieren möchten, müssen sie ein Storyboard öffnen, das vier Videos aus verschiedenen Blickwinkeln zeigt, um Videodetails zu präsentieren.

Storyboard zeigt unterschiedliche Blickwinkel der Szene

Im Storyboard können Nutzer im Beschreibungsfeld die gewünschten Videoanweisungen eingeben und Stil, Bildverhältnis, Dauer, Anzahl der Storyboards und Auflösung einstellen, um ein Video zu generieren.

Derzeit unterstützt Sora die Generierung von Videos bis zu einer Länge von 20 Sekunden und einer Auflösung von 1080p, mit drei wählbaren Bildverhältnissen: 16:9 / 1:1 / 9:16.

OpenAI erklärt, dass je weniger Worte in den Videoanweisungen verwendet werden, desto mehr füllt Sora die Details aus; je mehr Worte, desto stärker folgt es den Anweisungen des Nutzers.

Während der Live-Demonstration gab OpenAI im Beschreibungsfeld die Anweisung „Ein Weißreiher mit gelbem Schwanz steht im Bach“ ein, um diesen Videoclip am Anfang der Zeitleiste zu platzieren, und gab anschließend die Anweisung „Dieser Reiher taucht den Kopf ins Wasser und schnappt einen Fisch“ ein, um sie am Ende der gleichen Zeitleiste zu platzieren. Da die beiden Videoabschnitte nicht direkt verbunden sind, muss Sora Übergangsvideos generieren, um einen vollständigen Film zu erstellen.

Das Ergebnis zeigt, dass Sora klare Videos gemäß den Anweisungen generierte und einen sanften Übergang zwischen den beiden Videoabschnitten schuf, die das Video zusammenhängend und erzählerisch machen. Allerdings wurde im Video kein deutlicher Fisch dargestellt, obwohl Wasser spritzt, wenn der Reiher den Fisch greift.

Zwei Videos werden zu einem vereint

Zusätzlich können Nutzer ein Bild oder Video direkt hochladen, und Sora kann basierend auf deren Inhalt eine Textbeschreibung für das folgende Video generieren. Nutzer können die Anweisungen für Folgevideos nach Belieben ändern.

Zum Beispiel, wenn ein Bild eines Leuchtturms hochgeladen wird, erstellt Sora eine Karte, um das zukünftige Video zu beschreiben, und Nutzer können die Anweisungen anpassen und die Position auf der Zeitleiste ändern, um zu bestimmen, wann das Video abgespielt wird.

Leuchtturmbild hochladen, Sora beschreibt automatisch das nächste Video

Nach der initialen Videogenerierung wird Nutzern, wenn eine Optimierung erforderlich ist, das Remix-Tool angeboten, um Objekte zu ändern, wie z.B. Mammuts durch Roboter zu ersetzen oder Gesichtsausdrücke zu ändern. Sora bietet dafür drei Intensitätsstufen: fein, leicht und stark, um unterschiedlichen Änderungsanforderungen gerecht zu werden.

Mammut durch mechanisiertes Mammut ersetzt

Wenn Nutzer mit Teilen des generierten Videos zufrieden sind, können sie das Recut-Tool verwenden, um die bevorzugten Clips zu schneiden und durch Anweisungen das Video zu erweitern, um ein neues zu erstellen.

Darüber hinaus bietet Sora Loop- und erweiterte Funktionen wie Blend: Ersteres erlaubt es Nutzern, Videos unendlich zu wiederholen, dabei generiert Sora Details, damit Anfang und Ende des Videos nahtlos ineinander übergehen; letzteres erlaubt die Verschmelzung von zwei völlig unterschiedlichen Szenen.

Nicht nur ein Tool, sondern ein Weg zur Verwirklichung von AGI

Im Februar dieses Jahres stellte OpenAI die erste Generation von Sora vor, die es ermöglicht, basierend auf Benutzereingaben Videoclips mit einer Länge von bis zu einer Minute zu erstellen. Danach startete ein zehnmonatiger geschlossener Betatest, der nur bestimmten externen Personen wie visuellen Künstlern, Designern und Filmemachern zugänglich war.

Erst wenige Stunden vor Beginn der aktuellen Live-Übertragung tauchten die neuesten offiziellen Videos von Sora im Internet auf.

Während des geschlossenen Betatests von Sora erlangten ähnliche Produkte aus China wie Keling AI, Jidong AI und Shell AI bereits Anerkennung von Anwendern im Ausland.

Laut Similarweb, einem ausländischen Website-Analyse-Tool, erreichte Keling AI im November insgesamt 9,4 Millionen Besuche weltweit und übertraf damit Runway, ein vergleichbares ausländisches Produkt, mit 7,1 Millionen Besuchen. Unter den vorzeitig veröffentlichten Demo-Videos von Sora Turbo äußerten viele ausländische Nutzer, dass die Videoleistungen mit ähnlichen chinesischen Produkten vergleichbar seien.

Sam Altman hat erklärt, dass das Tempo der Updates für Sora hinter den Erwartungen zurückgeblieben ist, aufgrund der notwendigen Sicherstellung der Modell-Integrität und der Erweiterung der Rechnerkapazität.

Es soll berichtet worden sein, dass OpenAI eine Partnerschaft mit dem Halbleiterunternehmen Broadcom eingegangen ist, um KI-Chips für die Modellverwendung zu entwickeln, die frühestens 2026 eingeführt werden könnten.

Die Bedeutung von Sora für OpenAI geht weit über ein reines Video-Generierungs-Tool hinaus. Während der Live-Übertragung betonte Sam Altman, dass er möchte, dass AI Videos versteht und generiert, um die Art und Weise zu verändern, wie Menschen Computer verwenden. Gleichzeitig soll dies OpenAI auf dem Weg zur Realisierung allgemeiner künstlicher Intelligenz (AGI) helfen.

Allerdings gehen die Meinungen über diese Aussage auseinander. Jiang Daxin, CEO von Steps to Stars, sagte gegenüber "Intelligente Erscheinung", dass er OpenAIs Sora-Einführung als eine Möglichkeit sieht, die sich iterativ entwickelnde Multimodal-Generierungsfähigkeit zu erforschen, weshalb sich Steps to Stars auch auf einem ähnlichen Weg bewegt, um allgemeine KI-Technologien zu erforschen. Yann LeCun, Chef-Wissenschaftler für KI bei Meta, glaubt jedoch, dass die Generierung von Pixeln, um das Verhalten der Welt zu simulieren, Ressourcen verschwendet und zum Scheitern verurteilt ist.

Der Zeitplan für die Einführung allgemeiner KI ist bereits Teil des OpenAI-Plans. Sam Altman erklärte letzte Woche gegenüber den Medien, dass die ersten Anwendungsfälle allgemeiner KI bereits 2025 auftreten könnten, wobei es möglich wäre, eine sehr komplexe Aufgabe festzulegen, die die KI mit verschiedenen Werkzeugen abschließen würde.

„Die anfänglichen Auswirkungen allgemeiner KI könnten gering sein, aber letztlich werden sie stärker sein, als die Menschen sich vorstellen können. Wie bei jeder bedeutenden neuen Technologie wird eine Vielzahl von Arbeitsplätzen ersetzt werden.“

Vielleicht wird OpenAIs Sora durch die intensivere Nutzung zunehmend bedeutende Auswirkungen auf allgemeine künstliche Intelligenz haben, was OpenAI letztlich helfen wird, sein Endziel zu erreichen.